Datenwissen von A-Z

WIKI

WIKI

A wie:

A wie: Azure Data Factory

Einführung

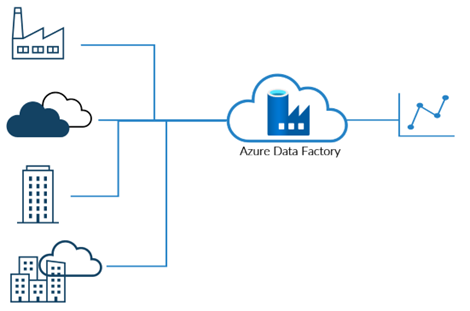

Azure Data Factory ist ein von Microsoft bereitgestellter cloudbasierter Datenintegrations- und Orchestrierungsdienst. Er ermöglicht Unternehmen die effiziente Verwaltung und Verarbeitung ihrer Daten (sowohl strukturiert als auch unstrukturiert) aus einer Vielzahl von Quellen, lokal und in der Cloud. Mithilfe einer intuitiven visuellen Benutzeroberfläche und leistungsstarker Funktionen können Benutzer datengesteuerte Workflows für die Datenverschiebung und -transformation erstellen, um ihre Daten einfach über verschiedene Systeme hinweg zu integrieren. Somit ist Azure Data Factory eine wertvolle Ergänzung für die Datenverwaltungsstrategie jedes Unternehmens.

Zusätzlich zur Datenverschiebung bietet Azure Data Factory auch eine breite Palette an Datentransformationsfunktionen, mit denen Benutzer ihre Daten einfach bereinigen, anreichern und transformieren können. Die integrierten Konnektoren und Integration mit anderen Azure-Diensten wie Azure HDInsight, Azure Machine Learning und Azure Synapse Analytics erleichtern die Durchführung komplexer Datentransformationen und -analysen.

Nutzen

- Azure Data Factory ist ein cloudbasierter Dienst von Microsoft, der es Unternehmen ermöglicht, ihre Daten einfach und effizient zu verwalten und zu verarbeiten.

- Durch die Skalierbarkeit des Dienstes können Organisationen ihre Ressourcen basierend auf ihren Datenverarbeitungsanforderungen einfach hoch- oder runterskalieren, ohne zusätzliche Investitionen in Hardware oder Infrastruktur tätigen zu müssen.

- Die Funktionen zur Datenintegration und -transformation von Azure Data Factory ermöglichen es Unternehmen, ihre Daten einfach zu verwalten und zu verarbeiten.

- Die integrierten Sicherheitsfunktionen wie Verschlüsselung und Zugriffskontrolle gewährleisten die Datensicherheit und die Einhaltung von Datenschutzbestimmungen.

- Die Integration von Azure Data Factory mit anderen Azure-Diensten wie Azure HDInsight, Azure Machine Learning und Azure Synapse Analytics ermöglicht es Unternehmen, tiefere Einblicke in ihre Daten zu gewinnen und datengestützte Entscheidungen zu treffen.

- Die visuelle, benutzerfreundliche Oberfläche erleichtert es Organisationen, ihre Datenpipelines zu verwalten und zu überwachen, was die Effizienz und Produktivität verbessert und den Zeitaufwand für die Datenverwaltung reduziert.

A wie: Azure DevOps

Einführung

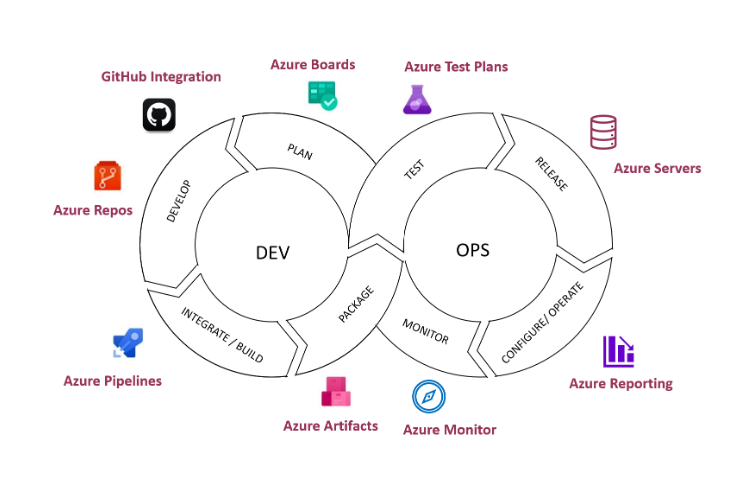

Azure DevOps bietet Entwicklerdienste für Support-Teams zur Arbeitsplanung, zur Zusammenarbeit bei der Code-Entwicklung und zur Erstellung und Bereitstellung von Anwendungen. Azure DevOps unterstützt eine Kultur und eine Reihe von Prozessen, die Entwickler und Projektmanager zusammenbringen, um die Softwareentwicklung abzuschließen. Es ermöglicht Unternehmen, Produkte in einem schnelleren Tempo zu erstellen und zu verbessern, als dies mit herkömmlichen Softwareentwicklungsansätzen möglich ist.

Architektur

Azure Boards ist in mehreren hierarchischen Ebenen organisiert, um Flexibilität und Anpassungsfähigkeit in verschiedenen Organisationen zu gewährleisten.

- Eine Organisation ist das oberste Element der Architektur. Ihre Anzahl ist innerhalb eines einzelnen Unternehmens unbegrenzt. Jede Organisation kann mit einem Azure AD verknüpft werden, um nach Personen innerhalb der Organisation zu suchen. Jede Organisation hat einen und nur einen Eigentümer, der die meisten Rechte hat.

- Ein Projekt ist das zweite Top-Element der Architektur. Es bietet eine Reihe von Komponenten für die Arbeitsplanung und die Zusammenarbeit bei der Softwareentwicklung, darunter auch Azure Boards. Jedes Projekt muss sich innerhalb einer Organisation befinden und es gibt eine weiche Begrenzung von 300 Projekten pro Organisation auf Azure DevOps Services (Cloud-Version), aber keine Begrenzung auf Azure DevOps On-Premise. Jedes Projekt hat einen oder mehrere Projektadminsitratoren.

- Azure Boards ist eine der Komponenten eines jeden Projekts. Andere Komponenten sind Azure Repos, Azure Pipelines und Azure Artifacts. Azure Boards besteht aus einer Backlog-Liste, einem Kanban Board, einem Query Builder und Lieferplänen.

- Ein Work Item ist das Kernelement eines jeden Projekts in Azure Boards. Ein Work Item kann viele Typen haben, die durch einen Projektprozess definiert werden.

Azure Boards

Azure Boards bietet eine Reihe von Agile-Tools zur Unterstützung der Planung und Verfolgung von Arbeit, Code-Fehlern und Problemen mit Kanban- und Scrum-Methoden. Es ist eine der vielen Komponenten, die in Azure DevOps enthalten sind.

Es bietet Ihnen eine Reihe von vordefinierten Arbeitselementtypen zur Unterstützung der Verfolgung von Features, User Stories, Bugs und Aufgaben. Sie können schnell loslegen, indem Sie Ihr Product Backlog oder Kanban-Board verwenden. Unabhängig davon, welche agile Methode Sie verwenden, Azure Boards unterstützt Sie mit den Tools, die Sie für die Umsetzung dieser Methode benötigen.

Mit dem Azure Boards-Webdienst können Teams ihre Softwareprojekte verwalten. Er bietet eine Vielzahl von Funktionen, darunter native Unterstützung für Scrum und Kanban, anpassbare Dashboards und integrierte Berichte. Diese Tools skalieren mit dem Wachstum Ihres Unternehmens.

Verfolgen Sie schnell und einfach User Stories, Backlog-Elemente, Aufgaben, Features und Bugs, die mit Ihrem Projekt verbunden sind. Verfolgen Sie die Arbeit, indem Sie Arbeitselemente basierend auf den für Ihr Projekt verfügbaren Prozess- und Arbeitselementtypen hinzufügen.

Nutzen

Azure DevOps ist eine vollständige, skalierbare und datengesteuerte Lösung für das Projektmanagement, die eine agile Methode bietet und gleichzeitig alles unter dem Microsoft Stack hält. Die Nutzung von Azure Boards bleibt auch für große Organisationen kosteneffizient und bringt Struktur mit allen möglichen Microsoft-Integrationen und benutzerdefinierten Projektprozessen.

A wie: Azure Functions

Einführung

Mit Azure Functions können Sie die Logik Ihres Systems als ereignisgesteuerte, leicht verfügbare Codeblöcke in Ihrer bevorzugten Programmiersprache mit automatischer Bereitstellung implementieren. Diese Codeblöcke werden als „Funktionen“ bezeichnet.

Funktionen

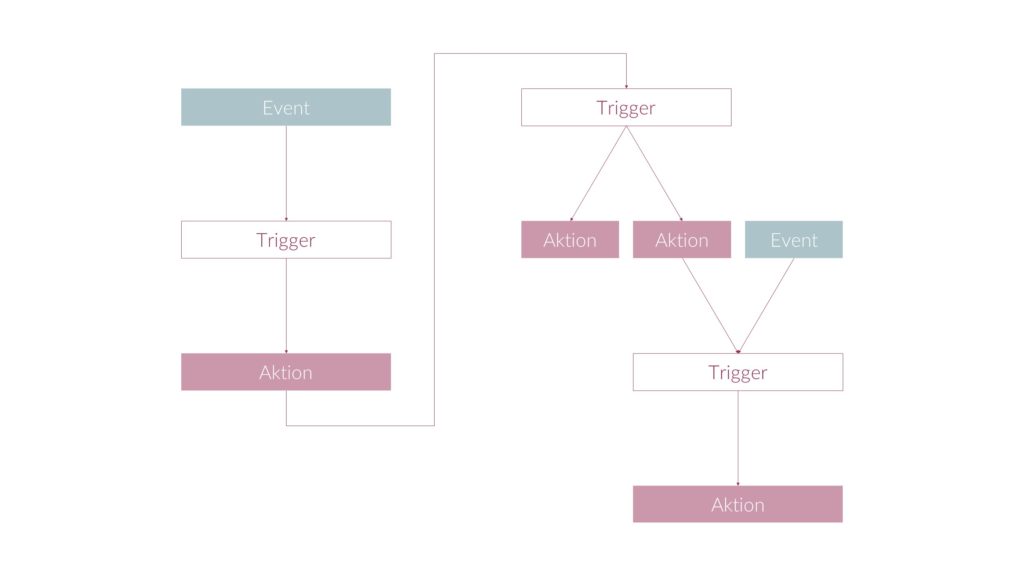

Eine Funktion ist das wichtigste Konzept in Azure Functions. Eine Funktion enthält zwei wichtige Teile – Ihren Code und eine Konfigurationsdatei, die function.json. Bei kompilierten Sprachen wird diese Konfigurationsdatei automatisch aus den Anmerkungen in Ihrem Code generiert. Bei Skriptsprachen müssen Sie die Konfigurationsdatei selbst erstellen.

Die Datei function.json definiert den Auslöser der Funktion, die Bindungen und andere Konfigurationseinstellungen. Jede Funktion hat einen und nur einen Auslöser. Die Laufzeitumgebung verwendet diese Konfigurationsdatei, um die zu überwachenden Ereignisse und die Art und Weise der Datenübergabe und -rückgabe bei der Ausführung einer Funktion zu bestimmen.

Anwendungen

Azure Functions kann für die Erstellung von Systemen verwendet werden, die auf eine Reihe kritischer Ereignisse reagieren. Egal, ob Sie eine Web-API erstellen, auf Datenbankänderungen reagieren, IoT-Datenströme verarbeiten oder Nachrichtenwarteschlangen verwalten – jede Anwendung benötigt eine Möglichkeit, Code auszuführen, wenn diese Ereignisse eintreten.

Mit Azure Functions sind Sie in der Lage, die Logik Ihres Systems in Funktionen zu implementieren, die jederzeit ausgeführt werden können, wenn Sie auf kritische Ereignisse reagieren müssen. Azure Functions deckt den Bedarf mit so vielen Ressourcen und Funktionsinstanzen wie nötig – aber nur solange wie nötig. Wenn die Anfragen zurückgehen, werden alle zusätzlichen Ressourcen und Anwendungsinstanzen automatisch abgeschaltet. Sie zahlen nur, solange Ihre Funktionen laufen.

Bearbeitung von Funktionen

Mit dem in das Azure-Portal integrierten Funktionseditor können Sie Ihren Code und Ihre function.json-Datei direkt inline aktualisieren. Dies wird nur für kleine Änderungen oder Proofs of Concept empfohlen – am besten verwenden Sie ein lokales Entwicklungstool wie Visual Studio Code.

Nutzen

Hier sind einige Vorteile von Microsoft Azure Functions:

- Skalierbarkeit: Azure Functions sind von Natur aus skalierbar und können automatisch an die Anforderungen angepasst werden.

- Kosteneffektivität: Azure Functions berechnen nur die tatsächlich ausgeführte Zeit und vermeiden damit unnötige Kosten für ungenutzte Kapazitäten.

- Einfache Integration: Azure Functions können einfach mit anderen Azure-Diensten wie Azure Event Grid, Azure Blob Storage oder Azure Cosmos DB integriert werden.

- Programmiersprachen: Azure Functions unterstützt mehrere Programmiersprachen wie C#, Java, JavaScript und Python.

- Entwicklerfreundlichkeit: Azure Functions bieten eine einfache und schnelle Möglichkeit, Funktionen zu erstellen und zu testen.

- Schnelle Bereitstellung: Azure Functions werden automatisch bereitgestellt und aktualisiert, so dass sich Entwickler auf ihre Funktionen konzentrieren können, anstatt sich um Infrastrukturdetails zu kümmern.

- Flexibilität: Azure Functions können auf verschiedene Arten ausgelöst werden, z.B. durch HTTP-Anforderungen, Zeitpläne oder Ereignisse von Azure-Diensten.

A wie: Azure Log Analytics

Monitoring von Log-Daten mit Azure Log Analytics

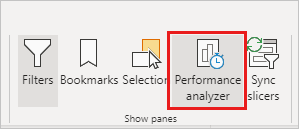

Sobald eine Premium Kapazität vorhanden ist, muss die Auslastung der Kapazitäten selbstständig verwaltet werden. Azure Log Analytics ist ein Dienst, welcher die Auswertung von Log-Daten in Power BI mithilfe der Power BI Analysis Services Engine ermöglicht und so mehr Transparenz in den Kapazitätsverbrauch pro Power BI Bericht uvm. liefert. Folgende Einblicke sind mit der Power BI Analysis Services Engine möglich:

- Zusammenfassung auf Arbeitsbereichs-Ebene

- Top Reports mit dem höchsten CPU Verbrauch

- Dataset (Semantisches Modell) Failure und Success Rate

- Datasets mit den meisten Abfragen + Dauer der Abfragen

- Berichtnutzung pro Tag/Monat/Woche

- uvm. mit Drillthroughs

- Engine Aktivitäten

- Kapazitäten auf Arbeitsbereichs-, Datenset-, und Report-Ebene

- Rechenzeiten (CPU time) mit Drillthrough auf Query-Ebene (z.B. Welche DAX-Query brauchte lange zum Durchführen?)

- uvm. mit Drillthroughs

- Dataset Refreshes

- Übersichten über die Refresh-Dauer verschiedener Datasets

- uvm. mit Drillthroughs

- Abfragestatistiken

- Top Queries mit dem höchsten CPU Verbrauch

- Queries die am längsten gebraucht haben

- uvm. mit Drillthroughs

- Nutzeraktivitäten

- Übersicht über die Top Nutzer diverser Berichte

- uvm. mit Drillthroughs

- Fehlerübersicht

- Details zu Fehlern (falls vorhanden)

A wie: Azure Machine Learning

Einführung Azure ML

Azure Machine Learning ist ein cloudbasierter Service von Microsoft, der Unternehmen dabei unterstützt, den Workflow von Machine Learning Projekten zu managen. Dies beinhaltet die Datenvorbereitung, das Training und Deployment von Modellen sowie das Monitoring und die Verwaltung von Modellen durch MLOps.

Azure Machine Learning Studio bietet verschiedene Optionen zur Entwicklung von Machine Learning Modellen an, darunter:

- Notebooks: Benutzer können Jupyter Notebooks direkt in Azure Machine Learning Studio erstellen und ausführen.

- Automated Machine Learning: Mit automatisierten ML-Experimenten können Modelle über eine Benutzeroberfläche erstellt werden.

- Azure Machine Learning Designer: Der Designer ermöglicht das Training und Deployment von Machine Learning Modellen, ohne dass Benutzer Code schreiben müssen. Durch Drag & Drop von Datensätzen und Komponenten kann eine Machine Learning Pipeline erstellt werden.

Um die Leistung dieser drei Methoden zu bewerten, können sie für das Trainieren eines Modells zur Vorhersage der Kreditwürdigkeit von Hauskreditkunden verglichen werden. Diese Vorhersage ermöglicht Unternehmen, automatisch festzustellen, welche Kunden für die Kreditvergabe geeignet sind, basierend auf den Angaben der Kunden.

Nutzen Azure ML

- Management des Workflows von Machine Learning Projekten

- Datenvorbereitung, Training und Deployment von Modellen

- MLOps zur Überwachung und Verwaltung von Modellen

- Möglichkeit, Modelle ohne eigenen Code zu schreiben zu trainieren und zu deployen

- Automatisierte ML-Experimente zur Erstellung von Modellen über eine Benutzeroberfläche

- Vergleich der Ergebnisse von verschiedenen Methoden zur Modellentwicklung

- Automatisierte Entscheidungen auf Basis von Kundenangaben

A wie: Azure Monitor

Einführung Azure Monitor

Azure Monitor unterstützt Ihren Betrieb dabei, die Leistung und Verfügbarkeit Ihrer Ressourcen zu maximieren und Probleme proaktiv zu erkennen.

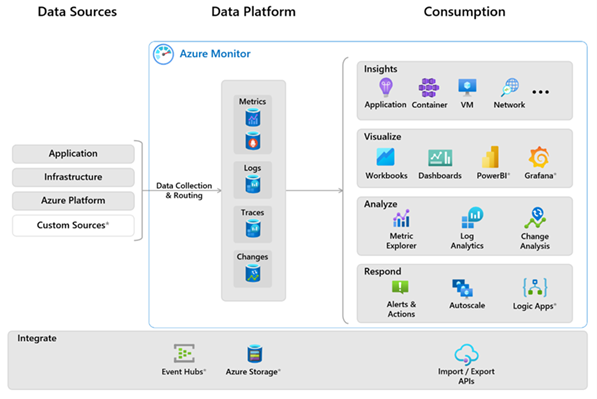

Das folgende Diagramm bietet eine allgemeine Ansicht von Azure Monitor.

Das Diagramm zeigt die Azure Monitor-Systemkomponenten:

- Die Datenquellen sind Arten von Daten, die von jeder überwachten Ressource gesammelt wurden. Die Daten werden gesammelt und an die Datenplattform weitergeleitet.

- Die Datenplattform besteht aus den Datenspeichern für gesammelte Daten. Die Azure Monitor-Datenplattform verfügt über Speicher für Metriken, Protokolle, Ablaufverfolgungen und Änderungen.

- Zu den Funktionen und Komponenten, die Daten nutzen, gehören Analysen, Visualisierungen, Erkenntnisse und Antworten.

- Dienste, die sich in Azure Monitor integrieren lassen und zusätzliche Funktionen bereitstellen, sind im Diagramm mit einem Sternchen * gekennzeichnet.

Azure Log Analytics Workspace

Ein Log Analytics-Arbeitsbereich sammelt Protokolle aus verschiedenen Datenquellen zur Datenanalyse. Es kann von anderen Diensten verwendet werden und zum Auslösen von Warnungen und Aktionen, beispielsweise mithilfe von Logic Apps. Der Log Analytics-Arbeitsbereich besteht aus Tabellen, die Sie konfigurieren können, um Ihr Datenmodell und die protokollbezogenen Kosten zu verwalten.

Azure Dashboards

Mit Azure Dashboards können Sie verschiedene Arten von Daten in einem einzigen Bereich im Azure-Portal kombinieren. Sie können das Dashboard optional mit anderen Azure-Benutzern teilen. Sie können die Ausgabe jeder Protokollabfrage oder Metrik als Diagramm zu einem Azure-Dashboard hinzufügen. Sie könnten beispielsweise ein Dashboard erstellen, das ein Diagramm mit Metriken, eine Tabelle mit Aktivitätsprotokollen, ein Nutzungsdiagramm von Application Insights und die Ausgabe einer Protokollabfrage anzeigt.

Logs Analytics

Die Log Analytics-Benutzeroberfläche im Azure-Portal unterstützt Sie beim Abfragen der von Azure Monitor gesammelten Protokolldaten, sodass Sie die gesammelten Daten schnell abrufen und analysieren können. Nachdem Sie Testabfragen erstellt haben, können Sie die Daten direkt mit Azure Monitor-Tools analysieren oder die Abfragen zur Verwendung mit Visualisierungen oder Warnungsregeln speichern.

A wie: Azure Purview

Einführung

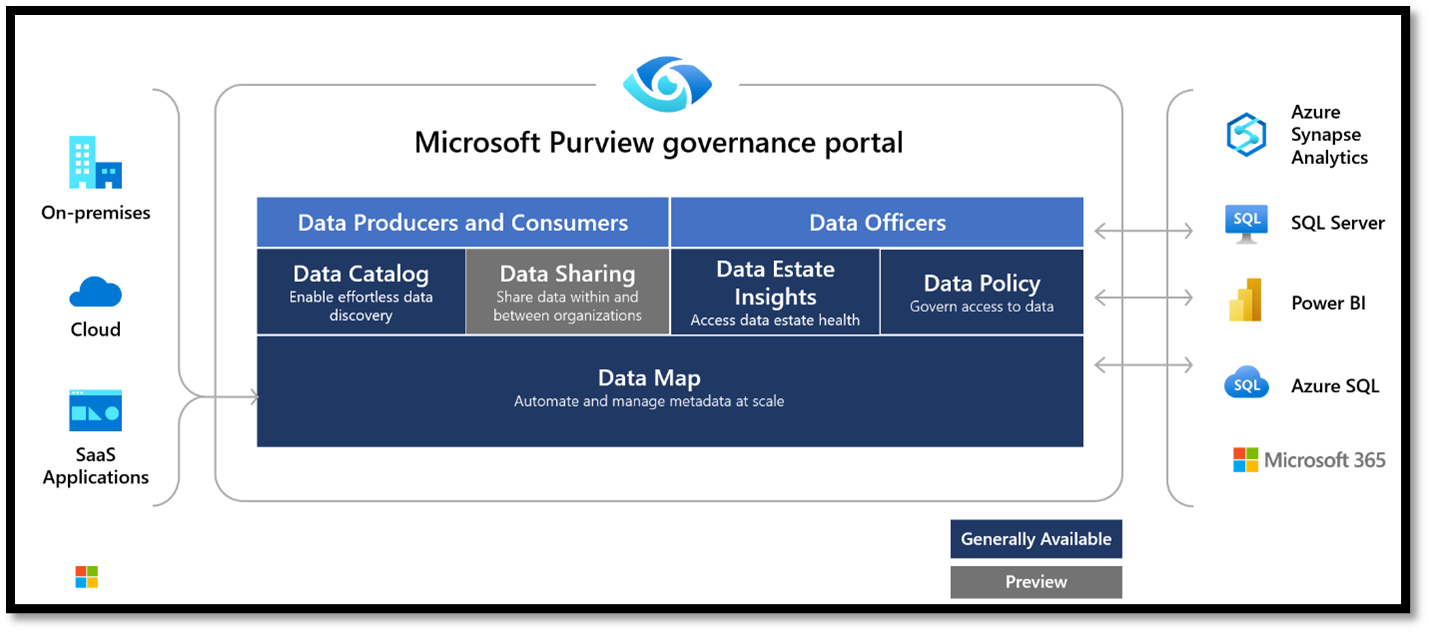

Das Governanceportal Microsoft Purview bietet umfassende Lösungen zur Datenverwaltung, die helfen können, lokale, Multicloud- und Software-as-a-Service-Daten (SaaS) zu verwalten. Mit dem Microsoft Purview-Governanceportal kann man folgendes erreichen:

- Erstellung einer ganzheitlichen und aktuellen Übersicht über die aktuelle Datenlandschaft, mithilfe einer automatisierten Datenermittlung, Klassifizierung und Verfolgung der Daten nutzen.

- Befähigen Sie Data Owners, ihren Datenbestand effektiv zu verwalten und zu schützen.

Nutzen

Nutzen

- Microsoft Purview unterstützt Unternehmen bei der optimalen Nutzung ihrer vorhandenen Informationsressourcen.

- Der Data Map macht Datenquellen leicht auffindbar und verständlich für die Benutzer, die die Daten verwalten.

- Der Data Catalog ermöglicht es Benutzern, schnell nach relevanten Daten zu suchen, sie zu verstehen und in ihrem bevorzugten Tool zu nutzen. Benutzer können auch Beiträge zum Katalog leisten, indem sie Datenquellen taggen, dokumentieren und kommentieren, sowie neue Datenquellen registrieren.

- Data Policies erlauben den einfachen Zugang zu Datenquellen intern zu verwalten

- Data Sharing öffnet Purview für externe Nutzer und erweitert die Zusammenarbeit auf Firmenpartner

Komponenten

Purview Scan

Bei einem Microsoft Purview Scan werden Metadaten über die verfügbaren Datenquellen gesammelt und organisiert. Dazu muss zunächst die Datenquelle ausgewählt werden, welche gescannt werden soll. Dies können Datenbanken, Data Lakes, Cloud-Speicher, Dateisysteme oder andere Datenquellen in Ihrer Azure-Umgebung sein. Anschließend können die Parameter für den Scan konfiguriert werden, wobei unter anderem die Scanhäufigkeit festgelegt wird. Hier gibt es die Möglichkeit, einen Trigger zur regelmäßigen Ausführung des Scans basierend auf bestimmten Datums- und Uhrzeitwerten zu definieren oder einen einmaligen Scan durchzuführen. Nach Abschluss des Scans können die Resultate im Purview-Governanceportal ausgewertet werden.

Purview Sources

Die Datenquellen können in Purview sowohl in einer Tabellenansicht als auch in einer Zuordnungsansicht dargestellt werden. Die Zuordnungsansicht liefert dabei eine hierarchische Anordnung der einzelnen Datenquellen. Beim detaillierten Blick in eine Sammlung werden alle Ressourcen aufgelistet, wobei für jede Ressource das Schema und weitere Eigenschaften ersichtlich ist.

Purview Glossar

Die Anlegung eines Unternehmensglossars bietet die Möglichkeit, bestimmte Begriffe zu definieren, um eine einheitliche Verwendung zu gewährleisten. Beim Hinzufügen eines neuen Begriffs wird der Name, eine Beschreibung und optional ein Akronym festgelegt. Zudem können die Begriffe durch die Angabe eines übergeordneten Begriffs hierarchisch angeordnet werden. Die Glossarbegriffe können anschließend zum Labeling einzelner Ressourcen verwendet werden.

Purview Datenkatalog

Der Datenkatalog in Purview bietet eine Übersicht zu allen verfügbaren Datenquellen. Jede Ressource kann dabei untersucht und bearbeitet werden. Beispielsweise kann das Schema einer Tabelle aktualisiert werden, indem Glossarbegriffe oder Klassifizierungen auf Spaltenebene hinzugefügt oder Datentypen geändert werden. Zudem sind die Eigenschaften und Kontaktdaten der Ressource bearbeitbar.

Purview Lineage

Mithilfe von Purview kann der Datenfluss über Azure Data Factory Pipelines von der Quelle bis zum Ziel dargestellt werden. Dadurch ist es leicht, die Herkunft der Daten nachzuvollziehen.

A wie: Azure Storage Accounts

Einführung

Azure Storage Accounts sind ein unverzichtbarer Bestandteil der Azure-Cloud-Plattform von Microsoft und ermöglichen Unternehmen und Entwicklern die Speicherung, Sicherung und den Abruf von Daten in der Cloud. Azure Storage zeichnet sich durch Skalierbarkeit, Sicherheit und Zuverlässigkeit aus und bietet somit eine ideale Lösung für die Datenspeicherung in der Cloud.

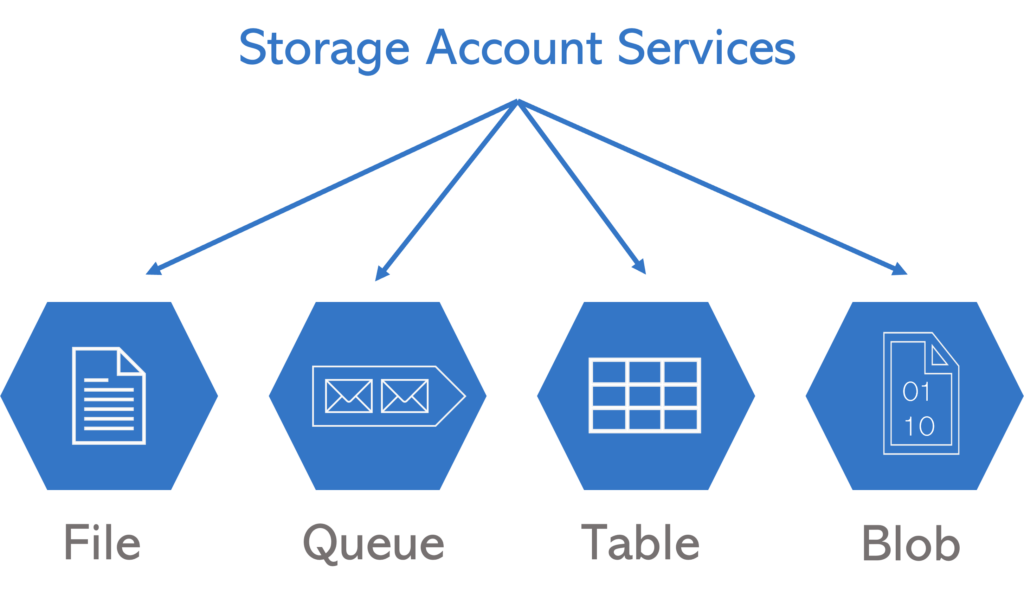

Jeder Azure Storage Account ist im Grunde ein Container, der dazu dient, Daten zu speichern. Es gibt verschiedene Arten von Azure Storage Accounts, wie beispielsweise Blob Storage, File Storage, Table Storage und Queue Storage. Jeder Typ bietet unterschiedliche Funktionen und Vorteile, die den spezifischen Anforderungen der Benutzer entsprechen.

- Blob Storage ist der am häufigsten verwendete Storage Account Service und eignet sich am besten für die Speicherung großer Binärdaten wie Bilder, Videos und Dokumente.

- File Storage ist ideal für die gemeinsame Nutzung von Dateien zwischen Anwendungen und Benutzern.

- Table Storage ermöglicht es Benutzern, strukturierte Daten in der Cloud zu speichern und abzurufen, während

- Queue Storage die Skalierung von Anwendungen unterstützt, die in der Cloud ausgeführt werden.

Nutzen

Azure Storage Accounts bieten eine Vielzahl von Vorteilen, die Unternehmen zu schätzen wissen werden. Dazu zählen insbesondere die Skalierbarkeit, Zuverlässigkeit und Sicherheit. Durch die Skalierbarkeit ist es jederzeit möglich, den Speicherbedarf zu erhöhen oder zu reduzieren, wodurch Unternehmen ihre Kosten flexibel steuern können, während sie sicherstellen, dass sie immer ausreichend Speicherplatz zur Verfügung haben. Azure Storage zeichnet sich auch durch eine hohe Verfügbarkeit und Ausfallsicherheit aus, so dass Daten jederzeit sicher und zuverlässig zugänglich sind.

B wie:

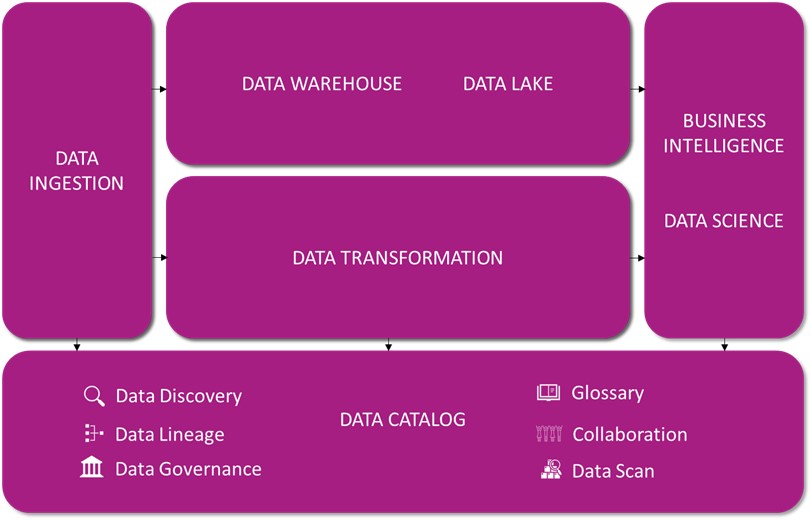

B wie: BI-Architektur

Einführung

Zur Auswahl des Business Intelligence Tools, welches sich am besten zur Erfüllung all Ihrer Ansprüche eignet, führen wir ein Tool-Benchmarking durch, um die unterschiedlichen Lösungen, die der Markt momentan bietet, miteinander zu vergleichen und zu bewerten. Anschließend entwickeln wir für Sie ein geeignetes, performanceorientiertes Datenmodell sowie ein Konzept zur Datenstrukturierung/-architektur. Zusätzlich kümmern wir uns um den reibungslosen Ablauf des ETL-Prozesses, wodurch Ihre Daten fehlerfrei aus verschiedensten Quellen in das Data Warehouse geladen werden.

Inhalte:

- Tool-Benchmarking

- Datenarchitektur

- Datenmodellierung (Queries)

- ETL

- Konnektoren

- Performanceoptimierungen

B wie: BI-Organisation

Einführung

Wir unterstützen Sie dabei, Fachkompetenzen für den Einsatz von Business Intelligence innerhalb eines Competence Centers in Ihrem Unternehmen aufzubauen. Zusätzlich sorgen wir dafür, dass Sie eine Reporting Factory für eine effiziente Aufbereitung der Unternehmensdaten einführen können, sodass die Daten in geeigneter Form den Verantwortlichen Ihres Unternehmens als Fundament für jegliche Entscheidungen zur Verfügung gestellt werden können.

Inhalte:

- Competence Center

- Reporting Factory

- Wissensmanagement

B wie: BI-Strategie

Einführung

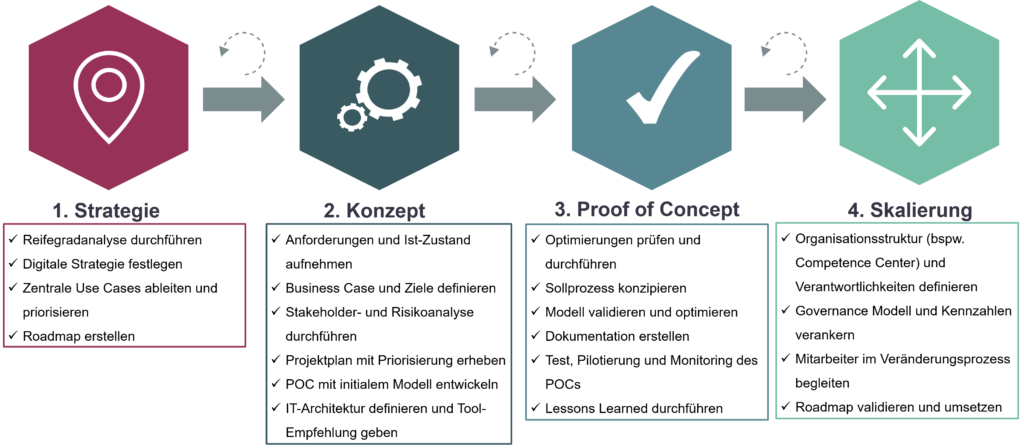

Wir möchten mit Ihnen zusammen eine passende, ganzheitliche und zukunftsgerichtete Business Intelligence-Strategie für Ihr Unternehmen entwickeln.

Dafür erstellen wir zunächst ein auf Ihre Anforderungen zugeschnittenes Vorgehensmodell. Außerdem analysieren wir Ihren Reifegrad, um einen Überblick zur aktuellen Leistungsfähigkeit Ihrer Prozesse zu erhalten. Anschließend entwerfen wir zur Visualisierung des gesamten Weges von der aktuellen Situation bis hin zum gewünschten Ergebnis eine BI-Roadmap, um unser Vorgehen und unsere Leistungen transparent zu machen. Zusätzlich führen wir eine Analyse aller bisher gesammelten, relevanten Daten Ihres Unternehmens durch.

Inhalte:

- Vorgehensmodell

- Reifegradanalyse

- BI-Roadmap

- Datenanalyse

C wie:

C wie: Cosmos DB

Einführung Azure Cosmos DB

Azure Cosmos DB ist eine mehrmodellige und flexible Datenbanklösung von Microsoft, welche sich als vollständig verwaltete NoSQL und relationale Datenbank für die moderne App-Entwicklung eignet. Es bietet eine skalierbare und hochleistungsfähige Lösung für das Speichern und Abfragen von strukturierten, halbstrukturierten und unstrukturierten Daten.

Vorteile Cosmos DB

- Globale Skalierbarkeit: Cosmos DB ermöglicht es, Daten über mehrere Regionen hinweg zu replizieren, um eine hohe Verfügbarkeit und Leistung zu gewährleisten. Sie können Ihre Datenbankinstanzen in verschiedenen Azure-Regionen verteilen und den Zugriff auf die Daten von überall auf der Welt ermöglichen.

- Mehrmodellige Unterstützung: Cosmos DB unterstützt verschiedene Datenmodelle, darunter Dokumente, Schlüssel-Wert, Spaltenorientierung, Graphen und Tabellen. Dadurch können Entwickler das für ihre Anwendung am besten geeignete Datenmodell auswählen und flexibel arbeiten.

- Konsistenzstufen: Cosmos DB bietet verschiedene Konsistenzstufen, von starker Konsistenz bis hin zu Eventual Consistency. Entwickler können die gewünschte Konsistenzstufe für ihre Anwendungen auswählen, je nach den Anforderungen an Datengenauigkeit und Latenz.

- SLA-gestützte Verfügbarkeit und Replikation: Cosmos DB gewährleistet eine hohe Verfügbarkeit mit einer SLA (Service Level Agreement) von 99,99 %. Die Daten werden automatisch innerhalb der Azure-Regionen repliziert, um Ausfallsicherheit und Datensicherheit zu gewährleisten.

- Elastische Skalierung: Mit Cosmos DB können Sie die Leistung und Speicherkapazität Ihrer Datenbank elastisch anpassen, um auf wechselnde Workload-Anforderungen zu reagieren. Sie können die Durchsatzkapazität und Speichergröße mit nur wenigen Klicks oder über eine API automatisch erhöhen oder verringern.

- Integrierte Unterstützung für globale Verteilung: Cosmos DB bietet integrierte Unterstützung für die Replikation von Daten über Azure-Regionen hinweg, um eine geringe Latenz und hohe Verfügbarkeit weltweit zu gewährleisten. Sie können die Datenreplikation in Echtzeit konfigurieren und die geografischen Standorte auswählen, an denen Ihre Daten gespeichert werden sollen.

- Entwicklerfreundlichkeit: Cosmos DB bietet eine Vielzahl von SDKs und APIs für verschiedene Programmiersprachen und Plattformen, einschließlich .NET, Java, Node.js, Python und mehr. Es ermöglicht Entwicklern, nahtlos mit ihren bevorzugten Tools und Sprachen zu arbeiten und schnell auf die Datenbank zuzugreifen.

- Eingebaute Sicherheit: Cosmos DB bietet integrierte Sicherheitsmechanismen wie Verschlüsselung im Ruhezustand und in Bewegung, Firewall-Regeln, Zugriffssteuerungen und rollenbasierte Zugriffskontrolle (RBAC). Dadurch werden die Daten vor unbefugtem Zugriff und Manipulation geschützt.

D wie:

D wie: Dashboard und Report

Einführung

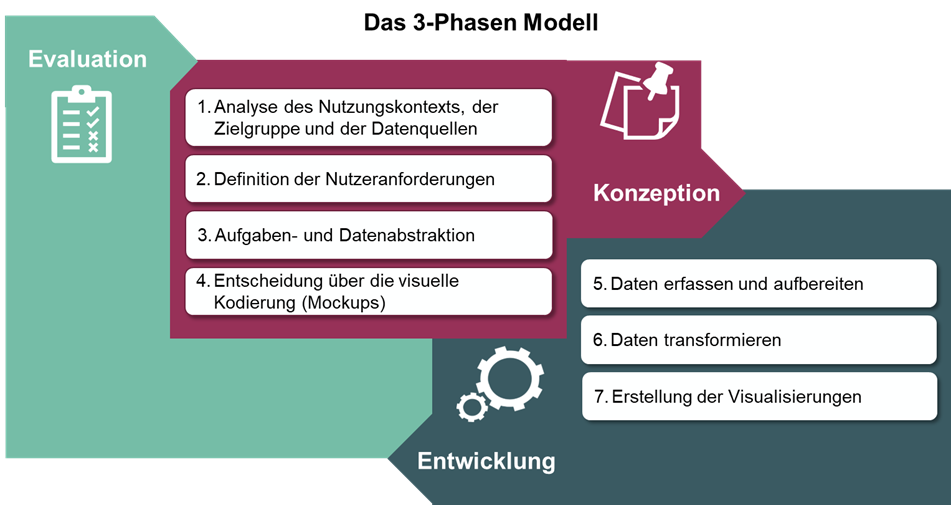

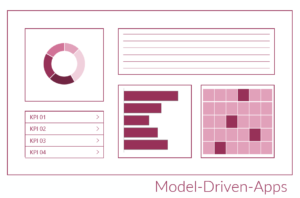

Mithilfe von Business Intelligence Berichten können Sie all Ihre Unternehmensdaten erfassen, auswerten und in Reports sowie Dashboards visualisieren, um dadurch Key Performance Indicators (KPIs) zu ermitteln und somit wichtige Erkenntnisse zur Verbesserung Ihrer Geschäftsprozesse zu gewinnen. Eine ungeeignete Darstellung von Daten kann schnell zu Missverständnissen oder Fehlinterpretationen führen, weshalb wir Sie gerne bei der Entwicklung des passenden Designs bzw. Layouts Ihrer Berichte, Dashboards und ScoreCards unterstützen.

Inhalte:

- 3-Phasen Modell (Dashboardentwicklung)

- Data Story Telling

- Mockups

- KPI

- ScoreCard

- Automatisierte Berichterstattung

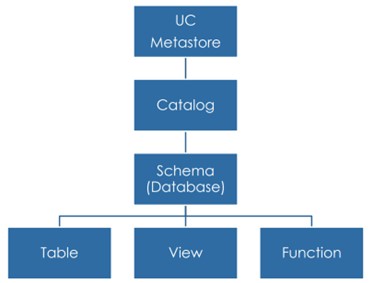

D wie: Databricks

Databricks ist eine Multi-Cloud Lakehouse Plattform basierend auf Apache Spark. Databricks wird auf den größten Cloud-Plattformen Microsoft Azure, Google Cloud und Amazon AWS angeboten. Es deckt den gesamten Prozess der Datenverarbeitung ab: Data Engineering, Data Science und Machine Learning.

Die Databricks Umgebung übernimmt die Verwaltung von Spark Clustern und bietet interaktive Notebooks zur Verarbeitung, Analyse und Visualisierung von Daten in mehreren Programmiersprachen. Die Aufsetzung und Steuerung von Jobs und Pipelines ermöglichen zudem die Automatisierung der Datenverarbeitung.

Zentrale Komponenten von Databricks sind dabei Apache Spark, Delta Lakes und MLflow.

Apache Spark

Durch den Einsatz von Apache Spark als Framework zur Datenverarbeitung eignet sich Databricks zur Analyse von Big Data und Entwicklung von Machine Learning Modellen, da Spark Cluster mit einer Vielzahl an Servern zur Datenverarbeitung nutzt, welche durch Skalierung eine fast unbeschränkte Rechenleistung bieten. Spark bietet zudem eine Schnittstelle zur Programmierung in verschiedenen Sprachen, wie Java, Scala, Python, R oder SQL.

Delta Lake

Delta Lake ist eine Open-Source Speicherschicht, die für die Verwaltung von Big Data in Data Lakes entwickelt wurde. Delta Lakes erhöhen die Zuverlässigkeit von Data Lakes, indem sie die Datenqualität und Datenkonsistenz von Big Data steigern und Funktionen aus traditionellen Data Warehouses hinzufügen. Delta Lakes unterstützen ACID-Transaktionen, skalierbare Metadaten und Time Traveling durch das Logging aller Transaktionen. Zudem sind Delta Lakes Spark kompatibel und nutzen standardisierte Datenformate, wie Parquet und Json.

Dadurch ermöglichen Delta Lakes die Bildung von einem Lakehouse, welches die Vorteile von Data Lakes und Data Warehouses kombiniert.

MLflow

MLflow ist eine Open-Source-Plattform zur Verwaltung des gesamten Machine-Learning-Lebenszyklus. Es wurde entwickelt, um den Prozess des Trainings, der Verwaltung und der Bereitstellung von Machine-Learning-Modellen zu vereinfachen. MLflow ermöglicht das Protokollieren und Verfolgen von Machine Learning Experimenten während des Modelltrainings und die einfache Bereitstellung von trainierten Modellen als Docker-Container, Python-Funktionen und RESTful API-Endpunkte. MLflow ist kompatibel mit verschiedenen Machine-Learning-Frameworks wie TensorFlow, PyTorch, Scikit-Learn und XGBoost. Es kann unter anderem in Jupyter Notebooks, Apache Spark, Databricks und AWS SageMaker genutzt werden.

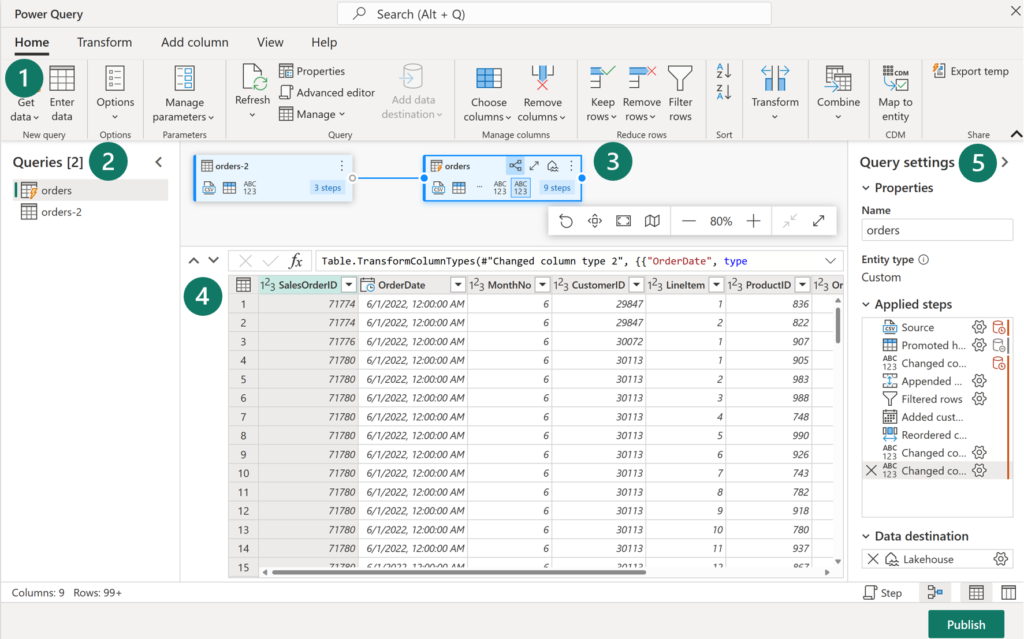

D wie: Dataflows Gen2

Dataflows (Gen2) sind eine cloudbasierte ETL-Plattform (Extrahieren, Transformieren und Laden), die es ermöglicht, skalierbare Datentransformationsprozesse zu erstellen und auszuführen. Diese Dataflows ermöglichen das Extrahieren von Daten aus verschiedenen Quellen, deren Transformation durch verschiedene Operationen sowie das Laden in ein definiertes Ziel. Die Verwendung von Power Query Online bietet auch eine grafische Benutzeroberfläche für die Durchführung dieser Aufgaben.

Das Ergebnis der Datenaufbereitung kann in eine neue Tabelle geladen, in eine Datenpipeline eingebunden oder von Datenanalysten als Datenquelle genutzt werden. Das Hauptziel von Dataflows (Gen2) besteht darin, eine einfache, wiederverwendbare Methode zur Durchführung von ETL-Aufgaben über Power Query Online bereitzustellen. Dataflows bieten eine Vielzahl von Transformationen und können manuell, nach einem Aktualisierungszeitplan oder als Teil einer Datenpipelineorchestrierung ausgeführt werden.

Durch die Verwendung von Dataflows (Gen2) können Daten konsistent aufbereitet und in das gewünschte Ziel verschoben werden. Zusätzlich erleichtern sie die Wiederverwendung und Aktualisierung von Daten. Ohne Dataflows müsste die Extraktion und Transformation von Daten manuell aus jeder Quelle erfolgen, was zeitaufwändig und fehleranfällig wäre.

Vorteile von Dataflows

- Konsistente Daten: Dataflows ermöglichen die Extraktion, Transformation und das Laden (ETL) von Daten in einer wiederholbaren und konsistenten Weise.

- Wiederverwendbare ETL-Logik: Dataflows ermöglichen die Implementierung von wiederverwendbarer ETL-Logik. Das bedeutet, dass einmal erstellte Transformationen und Workflows leicht in verschiedenen Projekten oder für unterschiedliche Datensätze wiederverwendet werden können.

- Self-Service-Zugriff: Dataflows ermöglichen es Self-Service-Benutzern, auf eine Teilmenge des Data Warehouse zuzugreifen. Dies fördert die Eigenständigkeit von Benutzern und reduziert die Abhängigkeit von spezialisierten IT-Abteilungen.

- Qualitätssicherung: Dataflows ermöglichen es Benutzern, Daten vor dem Laden in ein Ziel zu bereinigen und zu transformieren. Dies trägt zur Sicherung der Datenqualität bei, indem inkonsistente oder fehlerhafte Daten frühzeitig identifiziert und behoben werden.

- Einfache Datenintegration: Die Plattform stellt eine Low-Code-Schnittstelle bereit, die es ermöglicht, Daten aus verschiedenen Quellen einfach zu erfassen. Dies erleichtert die Integration von Daten ohne umfassende Programmierkenntnisse.

D wie: Data Warehouse

Ein Data Warehouse ist traditionell darauf ausgerichtet, strukturierte Daten aus verschiedenen Quellen zu integrieren und für die Analyse in einer optimierten, leistungsstarken Umgebung bereitzustellen.

Erstellung von einem Data Warehouse

Die Erstellung eines modernen Data Warehouse umfasst in der Regel folgende Schritte:

- Datenerfassung: Verschieben von Daten aus Quellsystemen in ein Data Warehouse

- Datenspeicher: Speichern der Daten in einem Format, das für die Analyse optimiert ist

- Datenverarbeitung: Transformieren der Daten zur Vorbereitung auf die Analyse

- Datenanalyse und -übermittlung: Analysieren der Daten, um Erkenntnisse zu gewinnen und diese bei Geschäftsentscheidungen für das Unternehmen zu berücksichtigen

Modellierung von Faktentabellen und Dimensionstabellen

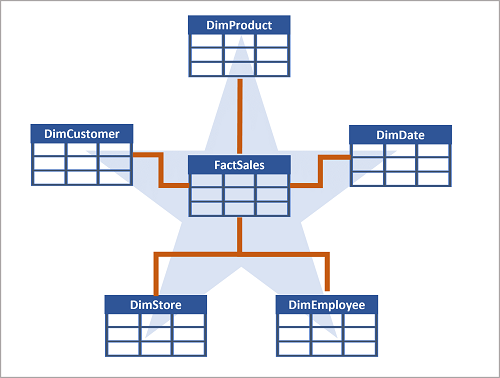

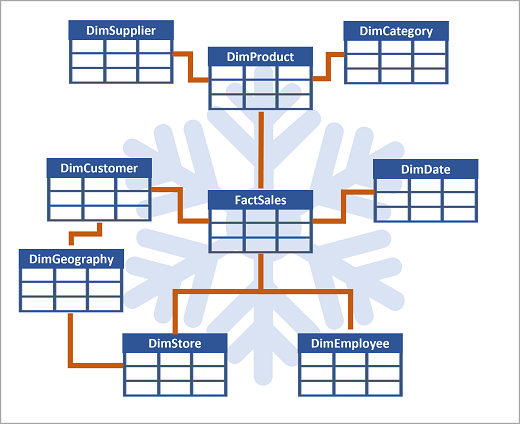

Die Tabellen in einem Data Warehouse sollten so organisiert sein, dass eine effiziente Analyse großer Datenmengen unterstützt wird. Diese Organisation wird häufig als dimensionale Modellierung bezeichnet, bei der Tabellen in Faktentabellen und Dimensionstabellen strukturiert werden.

- Faktentabellen enthalten die numerischen Daten, welche ausgewertet werden können. Faktentabellen umfassen in der Regel eine große Anzahl von Zeilen und sind die primäre Datenquelle für die Analyse. Beispielsweise kann eine Faktentabelle den Gesamtbetrag enthalten, der für Bestellungen an einem bestimmten Datum oder in einer bestimmten Filiale bezahlt wurde.

- Dimensionstabellen enthalten beschreibende Informationen zu den Daten in den Faktentabellen. Sie weisen in der Regel eine geringe Anzahl von Zeilen auf und werden verwendet, um Kontext für die Daten in den Faktentabellen bereitzustellen. Beispielsweise kann eine Dimensionstabelle Informationen zu den Kunden enthalten, die Bestellungen aufgegeben haben.

Häufig wird ein Data Warehouse als Sternschema organisiert, in dem eine Faktentabelle direkt mit den Dimensionstabellen verknüpft ist.

Falls es viele Ebenen gibt oder einige Informationen von verschiedenen Elementen geteilt werden, sollte stattdessen ein Schneeflockenschema genutzt werden.

D wie: Data Analytics vs. Business Intelligence

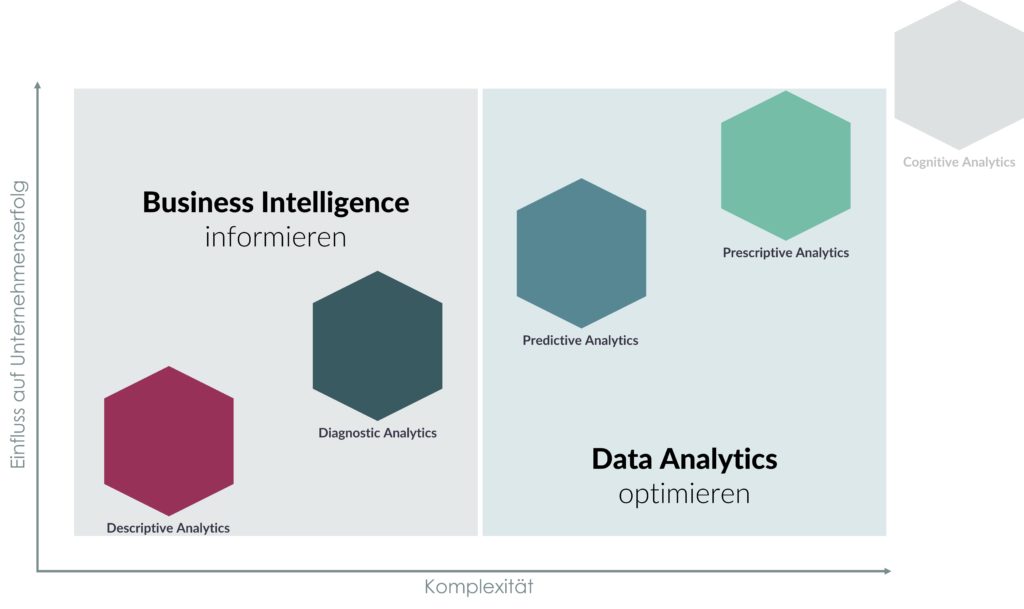

Unterschiede zwischen BI & Data Analytics

Descriptive Analytics

Bei der deskriptiven Analyse werden Daten statistisch ausgewertet, um festzustellen, was in der Vergangenheit passiert ist. Die deskriptive Analyse hilft einem Unternehmen zu verstehen, wie es funktioniert, indem sie den Beteiligten bei der Interpretation der Informationen hilft. Dies kann in Form von Datenvisualisierungen wie Diagrammen, Tabellen, Berichten und Dashboards geschehen.

Diagnostic Analytics

Die diagnostische Analyse geht bei den beschreibenden Daten noch einen Schritt weiter und bietet eine tiefere Analyse, um die Frage zu beantworten: Warum ist das passiert? Häufig wird die diagnostische Analyse auch als Ursachenanalyse bezeichnet. Dazu gehören Prozesse wie

- Data Discovery,

- Data Mining,

- Drill Down und

- Drill Through.

Predictive Analytics

Bei der prädiktiven Analyse werden historische Daten in ein maschinelles Lernmodell eingespeist, das wichtige Trends und Muster berücksichtigt. Das Modell wird dann auf aktuelle Daten angewendet, um vorherzusagen, was als Nächstes passieren wird.

Prescriptive Analytics

Die präskriptive Analyse hebt prädiktive Daten auf die nächste Stufe. Jetzt, da Sie eine Vorstellung davon haben, was wahrscheinlich in der Zukunft passieren wird, was sollten Sie tun? Es werden verschiedene Handlungsoptionen vorgeschlagen und die potenziellen Auswirkungen der einzelnen Optionen aufgezeigt.

Cognitive Analytics

Cognitive Analytics wendet menschenähnliche Intelligenz auf bestimmte Aufgaben an und vereint eine Reihe von intelligenten Technologien, darunter

- Semantik,

- Algorithmen der künstlichen Intelligenz,

- Deep Learning und

- maschinelles Lernen.

D wie: Data Asset

Data Asset ist ein Begriff, der sich auf Daten als Vermögenswerte oder Ressourcen eines Unternehmens oder einer Organisation bezieht. Dies bedeutet, dass Daten als wertvolle Güter betrachtet werden können, ähnlich wie physische Vermögenswerte wie Gebäude, Maschinen oder Fahrzeuge, Daten bilden die Geschäftsgrundlage von vielen Unternehmen.

Data Assets können aus verschiedenen Arten von Daten bestehen, einschließlich strukturierter Daten, wie sie beispielsweise in Datenbanken gespeichert werden, oder unstrukturierter Daten, wie Texte, Bilder oder Videos. Auch Prozessdaten oder Logdaten können Teil von Data Assets sein.

Nutzen von Data Assets

Unternehmen nutzen Data Assets für verschiedene Zwecke, wie beispielsweise

- zur Verbesserung der Entscheidungsfindung,

- zur Identifizierung von Trends oder

- zur Entwicklung neuer Produkte und Dienstleistungen.

Durch die Analyse von Data Assets können Unternehmen auch Betriebsabläufe optimieren, Risiken minimieren und Wettbewerbsvorteile erlangen.

Es ist wichtig, dass Unternehmen ihre Data Assets sorgfältig verwalten und schützen, da sie oft vertrauliche Informationen enthalten können. Ein Verlust oder Missbrauch von Daten kann erhebliche negative Auswirkungen auf das Unternehmen haben.

Insgesamt sind Data Assets ein wichtiger Bestandteil moderner Unternehmen und Organisationen. Durch die sorgfältige Verwaltung und Nutzung dieser Ressource können Unternehmen ihre Wettbewerbsfähigkeit verbessern und langfristigen Erfolg sichern.

Prozess eines Data Assets

Den Prozess der

- Beschaffung,

- Nachverfolgung,

- Nutzung und

- Optimierung

von Data Assets wird als Data Asset Management bezeichnet.

D wie: Data Catalog

Ein Data Catalog (zu Deutsch: Datenkatalog) ist eine Art Verzeichnis oder Register, das Informationen über Daten innerhalb eines Unternehmens oder einer Organisation enthält. Der Data Catalog ist in der Regel eine zentrale Datenbank, die Informationen über alle verfügbaren Daten und deren Eigenschaften enthält, wie zum Beispiel

- ihre Quelle,

- ihre Struktur,

- ihre Bedeutung oder

- ihren Verwendungszweck.

Zweck eines Datenkatalogs

Der Zweck des Data Catalog besteht darin, eine Übersicht über alle verfügbaren Daten im Unternehmen oder in der Organisation zu bieten und so die Auffindbarkeit und Nutzung der Daten zu erleichtern. Durch die Katalogisierung von Daten können Nutzer schnell und einfach auf die benötigten Daten zugreifen, ohne lange suchen zu müssen. Dies kann die Effizienz von Arbeitsabläufen erhöhen und die Entscheidungsfindung verbessern.

Der Data Catalog ist auch ein wichtiger Bestandteil des Datenmanagements, da er es den Verantwortlichen ermöglicht, den Zugriff auf Daten zu kontrollieren und sicherzustellen, dass sie korrekt verwendet werden. Darüber hinaus kann der Data Catalog helfen, die Datenqualität zu verbessern, indem er die Standardisierung von Daten und Metadaten fördert und so sicherstellt, dass alle Nutzer auf dieselben Informationen zugreifen.

Nutzen eines Data Catalogs

Moderne Data Catalogs verwenden oft Künstliche Intelligenz (KI) und Machine-Learning-Algorithmen, um die Verwaltung von Daten zu automatisieren und die Suche nach Daten zu erleichtern. Die Integration von Data Catalogs in das Datenmanagementsystem eines Unternehmens oder einer Organisation kann einen erheblichen Mehrwert schaffen, indem die

- Auffindbarkeit,

- Verfügbarkeit und

- Qualität

von Daten verbessert wird.

D wie: Data Driven Culture

Eine datengesteuerte Kultur ist eine Kultur, in der Daten als grundlegender Bestandteil der Entscheidungsfindungsprozesse eines Unternehmens verwendet werden und in der jede:r Mitarbeiter:In, unabhängig von Position, ermutigt wird, Daten zur Unterstützung der Arbeit zu nutzen. Eine Data Driven Culture sieht Daten als strategisches Gut und als Quelle von Wettbewerbsvorteilen.

Zu den wichtigsten Merkmalen einer datengesteuerten Kultur gehören:

- Datenorientierte Entscheidungsfindung: In einer datengesteuerten Kultur werden Daten als Grundlage und Antrieb für die Entscheidungsfindung auf allen Ebenen des Unternehmens genutzt. Entscheidungen beruhen auf der Analyse von Daten und nicht auf Intuition oder Vermutungen.

- Datenkenntnis: Mitarbeiter:Innen in einer datengesteuerten Kultur verfügen über die notwendigen Fähigkeiten und Kenntnisse, um Daten zu verstehen und mit ihnen zu arbeiten, und sind in Datenanalysetools und -techniken geschult.

- Zugänglichkeit von Daten: Eine datengesteuerte Kultur zeichnet sich durch einen einfachen Zugang zu Daten und Analysetools aus, der es den Mitarbeiter:Innen ermöglicht, mit Daten zu arbeiten und sie zu nutzen.

- Eine Kultur des Experimentierens: In einer datengesteuerten Kultur werden die Mitarbeiter:Innen ermutigt, mit Daten zu experimentieren und sie zu nutzen, um Wachstums- und Verbesserungsmöglichkeiten zu ermitteln.

D wie: Data Governance

Was ist Data Governance?

Data Governance beschreibt eine Reihe von Regeln, Verfahren und Standards, die sicherstellen sollen, dass Daten in Unternehmen

- qualitativ hochwertig sind,

- geschützt werden und

- sinnvoll genutzt werden können.

Dabei legt Data Governance fest, wer welche Daten nutzen darf und wie sie verwendet werden sollen. Außerdem definiert sie die Verantwortlichkeiten für die Qualität und Identifikation von einzelnen Datenbeständen sowie die Steuerung, Überwachung und Ausführung von datenbasierten Prozessen. Darüber hinaus regelt sie den Zugriff der Mitarbeiter auf relevante Daten.

Insgesamt hilft Data Governance Unternehmen dabei, den digitalen Wandel erfolgreich zu gestalten, indem sie sichere und wirtschaftliche Abläufe, konsistente Daten und valide Analyseergebnisse gewährleistet. Dadurch können Risiken gesteuert und Kosten reduziert werden, während gleichzeitig der größtmögliche Wert aus den vorhandenen Daten für das Unternehmen generiert wird.

Vorteile von Data Governance

Gemeinsames Datenverständnis

Durch Data Governance entsteht ein gemeinsames Verständnis der Daten, wodurch eine einheitliche Sicht auf die Daten und eine einheitliche Terminologie erreicht wird. Dabei können die einzelnen Geschäftseinheiten ihre Flexibilität behalten und dennoch auf eine einheitliche Datenbasis zugreifen.

Verbesserte Datenqualität

Ein gut durchdachter Data Governance-Plan sorgt für eine verbesserte Datenqualität, indem er die Genauigkeit, Vollständigkeit und Konsistenz der Daten sicherstellt. Dadurch wird gewährleistet, dass die Daten zuverlässig sind und für die verschiedenen Geschäftseinheiten nutzbar sind.

Durchgehende Compliance

Data Governance trägt zur durchgehenden Compliance bei, indem sie sicherstellt, dass gesetzliche Vorgaben wie die DSGVO (EU-Datenschutz-Grundverordnung), der US-HIPAA (Health Insurance Portability and Accountability Act) sowie branchenspezifische Anforderungen wie der PCI-DSS (Payment Card Industry Data Security Standards) eingehalten werden. Dadurch wird gewährleistet, dass das Unternehmen gesetzliche Vorgaben erfüllt und Strafen sowie Reputationsverluste vermieden werden können.

Single Source of Truth (SSoT)

Durch Data Governance können Organisationen eine 360-Grad-Sicht auf ihre Kunden und andere Geschäftseinheiten erlangen, indem sie eine „einzige Version der Wahrheit“ für zentrale Geschäftseinheiten festlegen und ein angemessenes Maß an Einheitlichkeit über verschiedene Einheiten und Geschäftsaktivitäten hinweg schaffen. Dadurch wird sichergestellt, dass alle Abteilungen und Geschäftsbereiche auf die gleichen Informationen zugreifen und eine konsistente Sicht auf die Geschäftsaktivitäten des Unternehmens haben.

Was Data Governance nicht ist

Data Governance ist nicht dasselbe wie Datenmanagement. Datenmanagement bezieht sich auf die Verwaltung des gesamten Lebenszyklus von Daten innerhalb einer Organisation. Data Governance ist ein zentraler Bestandteil des Datenmanagements und verbindet neun weitere Konzepte, wie beispielsweise

- Datenqualität,

- Referenz- und Stammdatenmanagement,

- Datensicherheit,

- Datenbankprozesse,

- Metadatenmanagement und

- Data Warehousing.

Data Governance ist auch nicht dasselbe wie Data Stewardship. Data Governance sorgt dafür, dass die richtigen Personen die richtigen Datenverantwortlichkeiten zugewiesen bekommen. Data Stewardship bezieht sich auf die notwendigen Aufgaben, um sicherzustellen, dass die Daten genau, kontrolliert und von den richtigen Benutzergruppen einfach zu finden und zu verarbeiten sind. Während es bei Data Governance in erster Linie um Strategie, Rollen, Organisation und Richtlinien geht, konzentriert sich Data Stewardship auf die Ausführung und Operationalisierung.

Data Governance ist auch nicht dasselbe wie Stammdatenmanagement. Das Stammdatenmanagement konzentriert sich darauf, wichtige Bereiche einer Organisation zu identifizieren und dann die Qualität dieser Daten zu verbessern. Es stellt sicher, dass Sie die vollständigsten und genauesten verfügbaren Informationen zu wichtigen Bereichen wie Kunden, Auftragnehmer, medizinische Dienstleister usw. haben.

D wie: Data Governance Framework

Was ist ein Data Governance Framework?

Ein Data Governance Framework ist ein systematischer Ansatz, der Richtlinien, Prozesse, Strukturen und Mechanismen bereitstellt, um die Verwaltung und Nutzung von Daten in einer Organisation zu steuern. Es bildet einen Rahmen, der sicherstellt, dass Daten von hoher Qualität, konsistent, sicher und vertrauenswürdig sind, um fundierte Geschäftsentscheidungen zu unterstützen und Risiken zu minimieren.

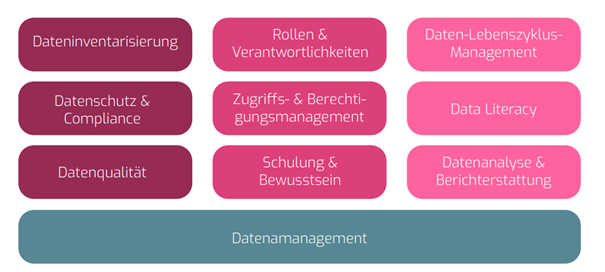

Das Data Governance Framework beinhaltet die Inventarisierung aller Datenquellen, die Einhaltung der Datenschutzrichtlinien und die Verbesserung der Datenqualität. Im nächsten Schritt werden die Rollen und Verantwortlichkeiten definiert, ein Berechtigungskonzept implementiert und das Bewusstsein der Mitarbeiter für das Data Governance gestärkt. Anschließend erfolgt das Management des Daten-Lebenszyklus, die Steigerung der Data Literacy im Unternehmen und die Analyse der Daten zur Unterstützung von Geschäftsentscheidungen.

Praxisbeispiele Data Governance Framework

Ein internationales Unternehmen möchte seine Data Governance verbessern, um sicherzustellen, dass die Daten korrekt, sicher und gesetzeskonform verwaltet werden. Das Unternehmen erkennt die Bedeutung von Daten für seine Geschäftsprozesse, Kundenbeziehungen und strategischen Entscheidungen. Daher plant es, eine umfassende Data-Governance-Strategie in folgenden Schritten zu implementieren:

Dateninventarisierung

Das Unternehmen beginnt damit, alle Datenquellen und -ressourcen zu identifizieren, die es besitzt oder nutzt.

Datenschutz und Compliance

Das Unternehmen überprüft seine Datenschutzrichtlinien und -verfahren, um sicherzustellen, dass sie den geltenden Datenschutzgesetzen und -bestimmungen entsprechen

Datenqualität

Das Unternehmen implementiert Prozesse, um die Datenqualität zu überwachen und zu verbessern

Zugriffs- und Berechtigungsmanagement

Das Unternehmen führt ein Zugriffsund Berechtigungsmanagement ein, um sicherzustellen, dass die Daten nur von autorisierten Personen eingesehen und bearbeitet werden können.

Daten-Lebenszyklus-Management

Das Unternehmen entwickelt Richtlinien und Verfahren für das Daten-Lebenszyklus-Management, von der Datenerfassung über die Speicherung, Archivierung bis zur Löschung.

Datenanalyse und Berichterstattung

Das Unternehmen implementiert Systeme zur Datenanalyse und Berichterstattung, um den Benutzern den Zugriff auf aktuelle und relevante Informationen zu ermöglichen. Es stellt sicher, dass die Datenanalysen auf vertrauenswürdigen und qualitativ hochwertigen Daten basieren.

Schulung und Bewusstsein

Das Unternehmen führt Schulungen und Trainings für die Mitarbeiter durch, um sie über die Bedeutung von Data Governance und die Einhaltung der Richtlinien zu informieren.

Fazit

Durch die Umsetzung des Data Governance Frameworks kann das Unternehmen seine Daten effektiver nutzen. Es verbessert die Datenqualität, schützt sensible Informationen, erhöht die Datenintegrität und stellt die Einhaltung der Datenschutzvorschriften sicher. Dadurch wird das Unternehmen in der Lage sein, fundierte Geschäftsentscheidungen zu treffen und einen Mehrwert aus seinen Daten zu ziehen.

D wie: Data Intelligence

Data Intelligence bezieht sich auf die Nutzung von Daten durch Sammlung, Verarbeitung und Analyse, um wertvolle Erkenntnisse zu gewinnen. Es ermöglicht fundierte Entscheidungen, verbesserte Geschäftsprozesse und wettbewerbsfähige Vorteile durch den Einsatz von fortschrittlichen Analysetechniken wie maschinellem Lernen und künstlicher Intelligenz.

Data Governance Reifegrad

Ein wichtiger Aspekt des Konzepts „Data Intelligence“ betrifft die Entwicklung von Data Intelligence Reifegraden, die den Fortschritt und die Effektivität einer Organisation bei der Nutzung von Daten zur Informationsgewinnung und Entscheidungsfindung bewerten. Im Folgenden werden die Reifegrade im Detail erläutert.

Data Integration (Stufe 1)

In dieser Ausgangsstufe stehen die Grundlagen der Datenintegration im Vordergrund. Daten werden aus verschiedenen Quellen extrahiert, transformiert und geladen (ETL) sowie in einem zentralen Repository gespeichert. Die Schwerpunkte liegen auf der Konsolidierung von Daten und der Gewährleistung ihrer Konsistenz. Datenintegrationstechnologien wie ETL-Tools werden verwendet, um den Prozess zu automatisieren und die Effizienz zu steigern.

Data Integrity (Stufe 2)

Datenintegrität bezieht sich auf die Qualität und Genauigkeit von Daten sowie darauf, sicherzustellen, dass Data Governance Reifegrad Daten während ihres gesamten Lebenszyklus korrekt, vollständig, konsistent und vor unerwünschten Änderungen geschützt bleiben. Ein höherer Data Integrity Reifegrad deutet auf eine stärkere Sicherung und Verwaltung der Datenqualität hin.

Data Intelligence (Stufe 3)

Auf dieser letzten Stufe des Reifegrads geht es darum, Daten in einen strategischen Vermögenswert zu verwandeln. Data Intelligence beinhaltet nicht nur die Sammlung und Analyse von Daten, sondern auch die Integration von Erkenntnissen in den Geschäftsprozess. Hier werden Daten genutzt, um innovative Lösungen zu entwickeln, Geschäftsmodelle zu verbessern und Wettbewerbsvorteile zu erzielen.

D wie: Data Literacy

Data Literacy bezieht sich auf die Fähigkeit einer Person, Daten zu verstehen, zu interpretieren, zu analysieren und kritisch zu bewerten. Eine datenkompetente Person ist in der Lage, Datenquellen zu identifizieren, Daten zu sammeln oder zu beschaffen, sie in sinnvolle Zusammenhänge zu setzen und daraus Erkenntnisse zu gewinnen.

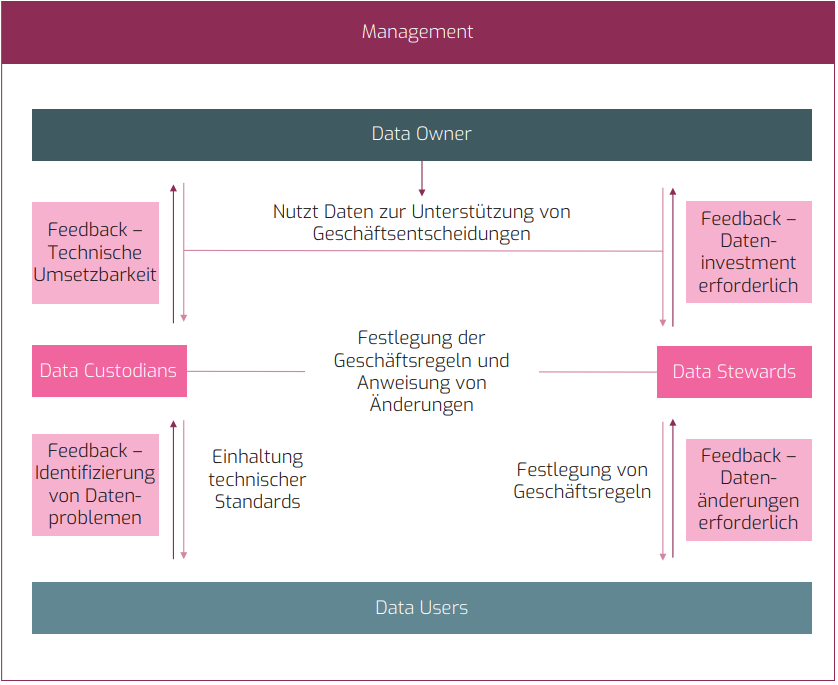

D wie: Data Ownership

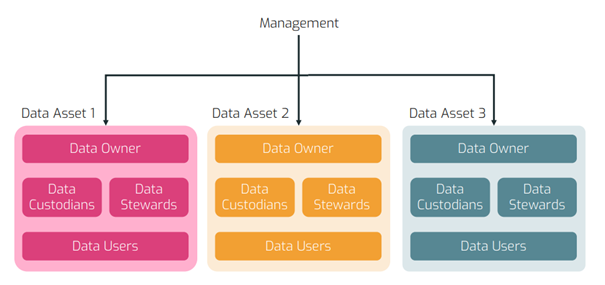

Definition von Rollen und Verantwortlichkeiten

Im nächsten Schritt werden klare Rollen und Verantwortlichkeiten für die Datenverwaltung definiert. Dies ermöglicht es, Data Owner und Data Stewards zu benennen, die für bestimmte Datendomänen und Datenkategorien verantwortlich sind. Die Data Owner sind für die Datenklarheit, Qualität und Aktualität zuständig, während die Data Stewards operative Aufgaben im Zusammenhang mit den Daten übernehmen. Zudem wird eine Data Governance Stabstelle (DGS) definiert. Die DGS verantwortet Standards, Prozesse, Policies und ist für den Bereich Organisationsveränderung und Data Literacy zuständig.

Klare Verantwortungen und Regeln sorgen dafür, dass Anwender die jeweiligen Ansprechpartner und festgelegte Prozesse zu den einzelnen Data Assets vorfinden.

Rollen & Begriffe im Detail

Data Steward

Data Stewardship-Programme stellen sicher, dass leicht zugängliche, konsistente und qualitativ hochwertige Daten für die Mitarbeiter entstehen. Ein Data Stewardship-Programm umfasst folgende Punkte: » Datenqualitätsprogramme inklusive Qualitätskennzahlen sowie Qualitätserkennungs- und Korrekturverfahren. » Informationen und Richtlinien zum Datenlebenszyklusmanagement. » Datenschutz und Risikomanagement. » Unternehmensrichtlinien und -verfahren für den Datenzugriff.

Data Owner

Ein Data Owner (Datenbesitzer) ist eine Einzelperson, eine Organisation oder eine Abteilung, die die Verantwortung für die Daten innerhalb eines Unternehmens oder einer Organisation trägt. Der Data Owner ist für die Kontrolle, den Schutz, die Integrität und die Verwaltung der Daten verantwortlich, die in seinem Besitz sind.

Data Custodian

Data Custodians (Datenverwalter) implementieren und pflegen die geschäftlichen und technischen Regeln zur Verwaltung eines Datensatzes, die vom zuständigen Data Steward festgelegt werden. Sie sind für die sichere Verwahrung, den Transport und die Speicherung von Daten verantwortlich.

Data Asset

Ein Data Asset (Datenwert) bezeichnet eine Datenressource oder einen Datensatz, der für ein Unternehmen, eine Organisation oder eine Einzelperson einen wirtschaftlichen oder strategischen Wert hat. Es handelt sich dabei um Daten, die einen Nutzen oder einen Beitrag zur Erreichung von Geschäftszielen liefern können. Data Assets können sowohl strukturierte Daten (z. B. Kundendaten, Verkaufsdaten, Bestandsdaten) als auch unstrukturierte Daten (z. B. Texte, Bilder, Videos) umfassen.

D wie: Data Quality

Datenqualität ist entscheidend für erfolgreiche Data Governance. Sie misst die Verlässlichkeit von Daten in Bezug auf Genauigkeit, Vollständigkeit, Gültigkeit und mehr. Die sechs wichtigsten Aspekte hierbei sind:

- Relevanz: Daten müssen dem vorgesehen Gebrauch entsprechen.

- Genauigkeit: Daten müssen fehlerfrei und präzise sein.

- Integrität: Daten müssen konsistent und zuverlässig sein.

- Aktualität: Daten müssen immer so zeitnah wie möglich verfügbar sein.

- Konsistenz: Daten sollten einheitlich und wiederspruchsfrei sein.

- Vollständigkeit: Daten sollten alle erforderlichen Infromationen haben.

Der Fokus auf diese Aspekte ist nicht nur wichtig, sondern auch essenziell für fundierte Geschäftsentscheidungen und den Erfolg eines Unternehmens. Um eine gute Datenqualität zu erreichen, erfordert es kontinuierliche Überwachung, schnelle Lösungen, Unterstützung von Geschäftsexperten, menschliche Verantwortung und das Verständnis von Datenqualität im Entscheidungsprozess.

D wie: Data Steward

Data Steward Definition

Ein Data Steward ist eine Person oder ein Team, das für die Verwaltung und Aufrechterhaltung der Datenqualität und Datenintegrität in einem Unternehmen verantwortlich ist. Ihr Hauptziel besteht darin, sicherzustellen, dass die gesammelten Daten korrekt, konsistent, aktuell und für die relevanten Stakeholder zugänglich sind.

Verantwortlichkeiten eines Data Stewards

a) Datenqualitätssicherung: Data Stewards überwachen die Datenqualität und führen Maßnahmen durch, um sicherzustellen, dass die Daten genau und vollständig sind. Sie entwickeln Standards, Richtlinien und Prozesse zur Datenbereinigung und -verbesserung.

b) Datenintegration und -harmonisierung: Sie stellen sicher, dass verschiedene Datensätze und Datenbanken innerhalb des Unternehmens miteinander integriert und harmonisiert werden. Dadurch wird die Konsistenz und Interoperabilität der Daten gewährleistet.

c) Metadatenverwaltung: Data Stewards erfassen und verwalten Metadaten, die Informationen über die Daten liefern. Dies umfasst beispielsweise Informationen zur Herkunft, Bedeutung, Struktur und Verwendung der Daten. Dadurch wird die Nachvollziehbarkeit und Verständlichkeit der Daten verbessert.

d) Datenschutz und Compliance: Sie stellen sicher, dass die Datenverwaltung den geltenden Datenschutzrichtlinien und -vorschriften entspricht. Sie unterstützen bei der Identifizierung und Bewältigung von Datenschutzrisiken und arbeiten eng mit Datenschutzbeauftragten zusammen.

e) Zusammenarbeit mit Stakeholdern: Data Stewards arbeiten mit verschiedenen Geschäftsbereichen zusammen, um deren Datenbedürfnisse zu verstehen und sicherzustellen, dass die bereitgestellten Daten ihren Anforderungen entsprechen. Sie fungieren als Bindeglied zwischen den Fachabteilungen und der IT-Abteilung.

D wie: Datenpodukte

Datenprodukte Definition

Im Kontext von Datenprodukten wird das Konzept von Produkten auf Daten angewendet. Das bedeutet, es gibt Produzenten, die Daten als ihr Produkt anbieten, und Konsumenten, die in ähnlicher Weise wie Kunden behandelt werden. Dies ergibt sich aus der Anwendung des Data-Mesh-Prinzips „Daten als Produkt“ auf die Art und Weise, wie Unternehmen Daten verwalten.

Datenprodukte werden von den entsprechenden Geschäftsbereichen verwaltet und einer Qualitätsprüfung unterzogen, bevor sie auf einem Self-Service-Marktplatz für alle im Unternehmen aufbereitet und zur Verfügung gestellt werden. Business-Anwender können diese Datenprodukte dann für ihre spezifischen Anwendungsfälle nutzen.

Der Mehrwert von Datenprodukten liegt darin, dass sie Unternehmen ermöglichen, große Mengen von Daten, die sie sammeln und generieren, schnell und effizient zu verwalten, zu organisieren und sinnvoll zu nutzen. Dies erleichtert den Nutzern der Daten die Gewinnung von Erkenntnissen, eine effiziente Nutzung und die Möglichkeit, auf dieser Grundlage fundiertere Entscheidungen zu treffen.

D wie: DAX

DAX, kurz für Data Analysis Expressions, ist eine leistungsstarke Sprache für Datenanalyse, die in Microsoft Power BI, Excel Power Pivot und anderen Microsoft-Produkten verwendet wird. DAX ermöglicht es Benutzern, komplexe Datenmodelle zu erstellen, die auf große Datenmengen zugreifen und mithilfe von Formeln, Funktionen und Aggregationen analytische Erkenntnisse gewinnen können.

Die Grundlagen von DAX

DAX wurde entwickelt, um die Erstellung von Datenmodellen zu vereinfachen und die Abfrage von Daten zu beschleunigen. Die Sprache basiert auf einer Reihe von Funktionen, die ähnlich wie in Excel verwendet werden können, um Daten zu filtern, aggregieren und berechnen. Eine wichtige Funktion des DAX ist die Verwendung von Tabellen, die in der Regel aus einer Datenbank oder einem anderen Datensatz stammen. Diese Tabellen können dann mithilfe von DAX-Funktionen und -Formeln miteinander verknüpft werden, um komplexe Datenmodelle zu erstellen.

DAX-Funktionen

Eine der nützlichsten Funktionen von DAX ist die Möglichkeit, Aggregationen durchzuführen. Aggregationen sind eine Möglichkeit, um aus einer großen Datenmenge eine Zusammenfassung zu erstellen, die einfacher zu analysieren ist. DAX bietet verschiedene Aggregationsfunktionen wie

- SUM,

- AVERAGE,

- COUNT und

- MIN/MAX.

Diese Funktionen können verwendet werden, um schnell und einfach Zusammenfassungen zu erstellen und Trends in den Daten zu identifizieren.

Eine weitere wichtige Funktion von DAX ist die Möglichkeit, Filter anzuwenden. Filter ermöglichen es Benutzern, Daten zu filtern und nur die Daten anzuzeigen, die für ihre Analyse relevant sind. Filter können auch in Verbindung mit Aggregationsfunktionen verwendet werden, um genaue Ergebnisse zu erzielen. DAX bietet verschiedene Filterfunktionen wie

- ALL,

- FILTER und

- CALCULATETABLE,

die Benutzer:Innen die Flexibilität geben, ihre Datenanalyse auf ihre Bedürfnisse anzupassen.

Code-Beispiele

SUM (gibt die Summe der Spalte ‚Column‘)

SUM(‚Table'[Column])

AVERAGE (gibt den Durchschnittswert der Spalte ‚Column‘)

AVERAGE(‚Table'[Column])

CALCULATE (gibt die Summe der Spalte ‚Column‘, welche das Wort „Value“ in Column2 haben)

CALCULATE(SUM(‚Table'[Column]), ‚Table'[Column2] = „Value“)

Wenn Sie mehr über DAX und seine Anwendung in der Datenanalyse oder Business Intelligence erfahren möchten zögern Sie nicht uns zu kontaktieren.

D wie: Deep Learning

Definition von Deep Learning

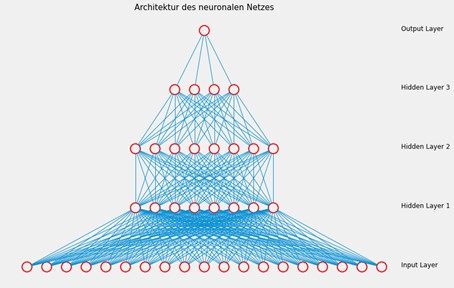

- Deep Learning ist eine fortgeschrittene Form des Machine Learning, die auf künstlichen neuronalen Netzwerken basiert.

- Die Netzwerke bestehen aus mehreren Schichten von Neuronen, die Daten durch komplexe Transformationen verarbeiten.

- Deep Learning ist besonders effektiv bei der Verarbeitung unstrukturierter Daten wie Bildern, Texten und Sprache.

- Technologien zur Entwicklung von Deep Learning Modellen sind beispielsweise TensorFlow, Keras und PyTorch

Methoden im Deep Learning

- Artificial Neural Networks

- Convolutional Neural Networks

- Recurrent Neural Networks

- Deep Reinforcement Learning

- Generative Adversarial Networks

- AutoEncoders

Anwendungsmöglichkeiten im Deep Learning

- Bilderkennung

- Sprachverarbeitung

- Autonomes Fahren

- Generative KI

D wie: Delta Lake

Delta Lake ist eine Open-Source Speicherschicht, die für die Verwaltung von Big Data in Data Lakes entwickelt wurde. Delta Lakes erhöhen die Zuverlässigkeit von Data Lakes, indem sie die Datenqualität und Datenkonsistenz von Big Data steigern und Funktionen aus traditionellen Data Warehouses hinzufügen.

Dadurch ermöglichen Delta Lakes die Bildung von einem Lakehouse, welches die Vorteile von Data Lakes und Data Warehouses kombiniert.

Delta Tabellen

Deltatabellen sind Schemaabstraktionen für Datendateien, die im Deltaformat gespeichert sind. Für jede Tabelle legt das Lakehouse einen Ordner mit Parquet-Datendateien und einem Ordner namens _delta_log an, in dem die Transaktionsdetails im JSON-Format protokolliert werden.

Vorteile eines Delta Lakes

- Durch Relationale Tabellen werden Abfrage- und Datenänderungen unterstützt, sodass wie in einem relationalen Datenbanksystem Datenzeilen ausgewählt, eingefügt, aktualisiert und gelöscht werden können.

- Delta Lakes unterstützen ACID-Transaktionen, sodass bei Datenänderungen die Atomarität (Transaktionen werden als eine einzelne Arbeitseinheit abgeschlossen), Konsistenz (Transaktionen verlassen die Datenbank in einem konsistenten Zustand), Isolation (laufende Transaktionen können sich nicht gegenseitig beeinträchtigen) und Dauerhaftigkeit (wenn eine Transaktion abgeschlossen ist, werden die vorgenommenen Änderungen dauerhaft gespeichert) gewährleistet wird.

- Da alle Transaktionen im Transaktionsprotokoll gespeichert werden, können mehrere Versionen jeder Tabelle nachverfolgt und mithilfe von Zeitreisen frühere Versionen wiederhergestellt werden.

- Delta Lakes sind Spark kompatibel und nutzen standardisierte Datenformate, wie Parquet und Json. Zudem können Deltatabellen in SQL abgefragt werden.

- Spark bietet über die Spark Structured Streaming-API native Unterstützung für Streaming-Daten. Delta Lake Tabellen können dadurch sowohl als Senken als auch als Quellen für Batch- und Streaming-Daten dienen.

D wie: Denodo

Denodo, eine bekannte Datenvirtualisierungsplattform, spielt eine entscheidende Rolle im Kontext von Data Governance. Data Governance ist der Prozess, der sicherstellt, dass Daten in einer Organisation effizient und verantwortungsvoll verwaltet werden, und Denodo ist ein leistungsstarkes Werkzeug, um dieses Ziel zu erreichen.

Insgesamt unterstützt Denodo Data Governance, indem es die Integration, Kontrolle, Qualität und Transparenz von Daten verbessert. Die Plattform erleichtert die Einhaltung von Datenschutz- und Compliance-Anforderungen, was in der heutigen datengetriebenen Geschäftswelt von entscheidender Bedeutung ist.

Hier sind einige wichtige Punkte in Bezug auf Denodo und Data Governance:

Datenintegration und Zugriffskontrolle

Denodo ermöglicht eine nahtlose Integration von Daten aus verschiedenen Quellen, einschließlich heterogener Datenbanken und Anwendungen. Durch die Zentralisierung von Datenzugriff und -kontrolle können Organisationen sicherstellen, dass nur autorisierte Benutzer auf bestimmte Daten zugreifen.

Datenqualität und -konsistenz

Data Governance beinhaltet oft die Aufrechterhaltung von Datenqualität und Konsistenz. Mit Denodo können Datenbereinigung und -transformation durchgeführt werden, um sicherzustellen, dass die Daten hochwertig und konsistent sind, bevor sie in Data-Governance-Initiativen einfließen.

Metadatenverwaltung

Denodo bietet umfangreiche Metadatenverwaltungsfunktionen, die dazu beitragen, den Ursprung und die Bedeutung der Daten zu dokumentieren. Dies ist entscheidend für die Einhaltung von Datenschutzbestimmungen und die Verfolgung von Datenflüssen.

Datenzugriffsrichtlinien

Durch die Erstellung von Datenzugriffsrichtlinien und -kontrollen in Denodo können Organisationen sicherstellen, dass Daten nur von berechtigten Personen eingesehen und verwendet werden.

Data Lineage und Auditing

Data Governance erfordert oft die Möglichkeit, den Datenfluss zu verfolgen und zu überwachen. Denodo ermöglicht dies durch Data-Lineage-Funktionen und Auditing, um sicherzustellen, dass Datenbewegungen nachvollziehbar sind.

Zusammenarbeit und Reporting

Denodo erleichtert die Zusammenarbeit zwischen verschiedenen Abteilungen in Bezug auf Daten und bietet leistungsstarke Reporting-Funktionen, um Einblicke in Datenverwendung und -qualität zu gewinnen.

H wie:

H wie: Hyperparameter

Was sind Hyperparameter bei neuronalen Netzen

Beispiele für Hyperparameter von neuronalen Netzen sind die

- Lernrate,

- Batchgröße und

- Menge an Epochen sowie

- die Anzahl an Hidden Layers und

- die Anzahl deren Neuronen.

Details zu Architektur & Funktionsweise neuronaler Netze, Lernrate, Batchgröße, Epochen, Hidden Layers, Neuronen, Aktivierungsfunktion sowie Kostenfunktion findet ihr im Impuls Architektur und Funktionsweise von neuronalen Netzen.

I wie:

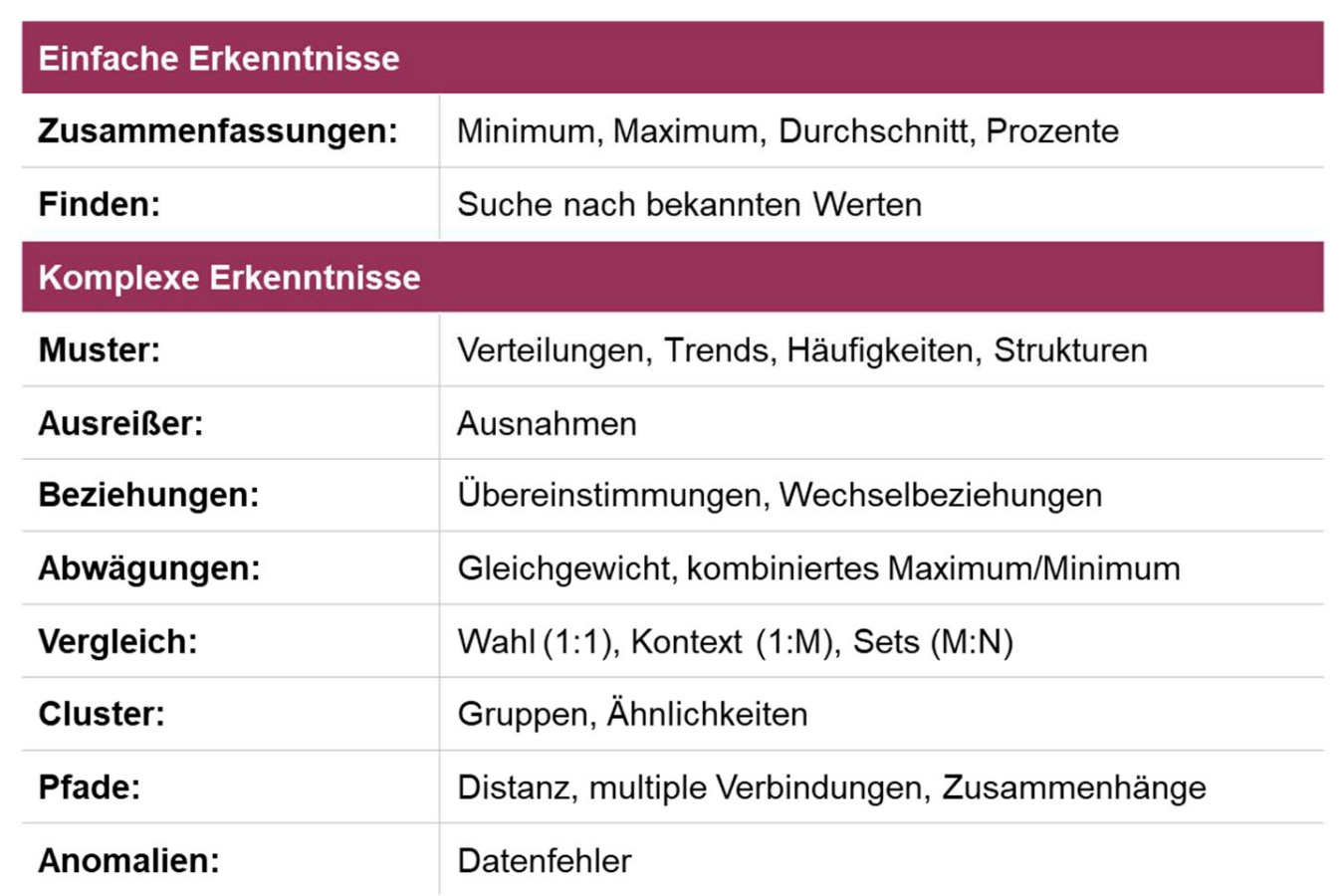

I wie: Informationsvisualisierung

Was ist Informationsvisualisierung?

Die Informationsvisualisierung ist ein Prozess, bei dem Daten und Informationen mithilfe visueller Darstellungen in graphischer Form dargestellt werden, um sie verständlicher, interpretierbarer und zugänglicher zu machen. Das Ziel der Informationsvisualisierung besteht darin, komplexe Daten und Zusammenhänge auf eine Weise zu präsentieren, die es den Menschen ermöglicht, Muster, Trends, Abweichungen und Erkenntnisse schnell zu erkennen.

Einige bekannte Beispiele für Informationsvisualisierung sind Balkendiagramme, Liniendiagramme, Tortendiagramme, Streudiagramme, geografische Karten, Word Clouds und Heatmaps. Informationsvisualisierung spielt eine wichtige Rolle in der heutigen datengesteuerten Welt und ermöglicht es Menschen, Daten effektiv zu nutzen, um bessere Entscheidungen zu treffen und komplexe Informationen zu verstehen.

K wie:

K wie: Künstliche Intelligenz (KI/AI)

Definition Künstliche Intelligenz (KI)

- Künstliche Intelligenz ist ein Zweig der Informatik.

- Es bezeichnet die Fähigkeit von Maschinen, selbstständig Aufgaben auszuführen, für die normalerweise menschliche Intelligenz erforderlich ist, beispielsweise logisches Denken, Problemlösung und das Lernen aus Erfahrungen.

- Teilbereiche der Künstlichen Intelligenz sind unter anderem Spracherkennung, Bildverarbeitung und Entscheidungsfindung.

- KI-Systeme werden entweder auf Regeln basierend oder durch maschinelles Lernen entwickelt.

Anwendungsmöglichkeiten von Artificial Intelligence (AI)

- Systeme zur Problemlösung und Entscheidungsfindung

- Chatbots

- Expertensysteme

- Spielautomaten

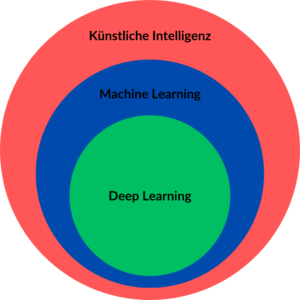

Teilgebiete von KI

Während KI den Oberbegriff für Maschinenintelligenz darstellt, ist Machine Learning eine Technik, die es Maschinen ermöglicht, aus Erfahrungen zu lernen, und Deep Learning ist eine spezifische Methode des Machine Learnings, die auf tiefen neuronalen Netzwerken basiert.

Weitere Teilgebiete der künstlichen Intelligenz sind unter anderem Robotik, Expertensysteme und Natural Language Processing.

L wie:

L wie: Lakehouse

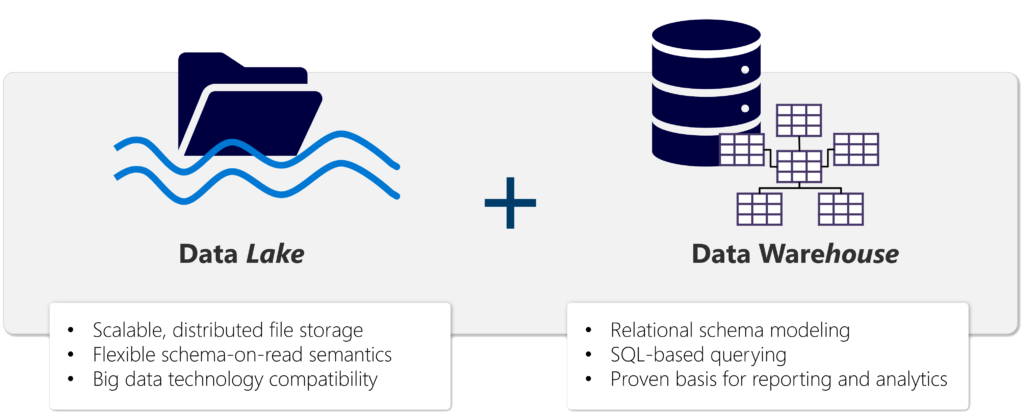

Ein Lakehouse ist eine Architektur, die Elemente sowohl von Data Warehouses als auch von Data Lakes kombiniert. Diese Kombination soll die Vorteile beider Ansätze nutzen, um eine umfassendere und flexiblere Plattform für die Verwaltung und Analyse von Daten zu schaffen.

Ein Data Warehouse ist traditionell darauf ausgerichtet, strukturierte Daten aus verschiedenen Quellen zu integrieren und für die Analyse in einer optimierten, leistungsstarken Umgebung bereitzustellen. Data Lakes hingegen sind flexiblere Speicherumgebungen, die eine breite Palette von strukturierten, unstrukturierten und halbstrukturierten Daten in ihrem nativen Format aufnehmen können.

Lakehouses kombinieren die SQL-basierten Analysefunktionen eines relationalen Data Warehouse mit der Flexibilität und Skalierbarkeit eines Data Lake. Ein Lakehouse ermöglicht es Unternehmen, sowohl strukturierte als auch unstrukturierte Daten in einem zentralen Repository zu speichern und sie für Analysezwecke zu nutzen, unabhängig von der Datenform oder -quelle.

Vorteile eines Lakehouses

- Lakehouses verwenden Spark- und SQL-Engines, um große Datenmengen zu verarbeiten und Maschinelles Lernen zu unterstützen.

- Lakehouse-Daten sind in einem Schema-on-Read-Format organisiert. Das bedeutet, dass Sie das Schema nach Bedarf definieren, anstatt ein vordefiniertes Schema nutzen.

- Lakehouses unterstützen ACID-Transaktionen (Atomicity, Consistency, Isolation, Durability – Unteilbarkeit, Konsistenz, Isolation, Dauerhaftigkeit) mithilfe von Delta Lake-formatierten Tabellen für Datenkonsistenz und -integrität.

- Bei Lakehouses handelt es sich um einen einzigen Standort für Data Engineers, Data Scientists und Datenanalysten, um auf Daten zuzugreifen und diese zu verwenden.

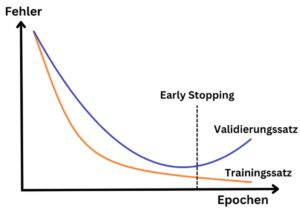

L wie: Lernen von Algorithmen

Lernen am Beispiel von neuronalen Netzen

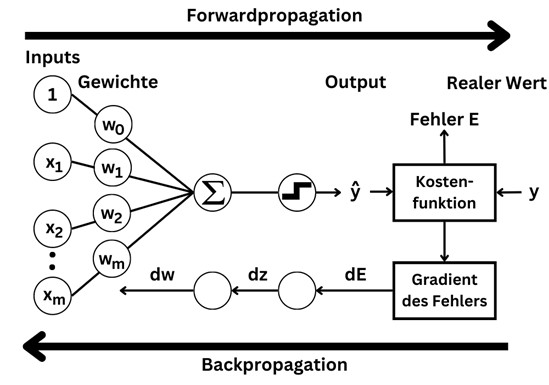

Beim Training eines neuronalen Netzes geht es darum, die Gewichte der Koeffizienten einzustellen. Je mehr Kanten es gibt, desto mehr Parameter muss das Modell lernen. Zum Lernen werden Trainingsdaten mit (x, y) Wertepaaren benötigt, wobei x den Input-Vektor mit den Werten für die einzelnen Features beschreibt und y die Zielvariable(n) enthält. Während des Trainings passt das neuronale Netz die Gewichte der Kanten so an, dass die Output-Neuronen möglichst ähnliche Werte zu y generieren, wenn x als Eingabewerte an die Input Layer übergeben wird.

Das neuronale Netz erzeugt durch eine Forwardpropagation von der Input Layer zur Output Layer Vorhersagen und beim Training lernt das neuronale Netz die richtige Einstellung der Parameter dadurch, dass der Fehler bei der Backpropagation in der entgegengesetzten Richtung zurückgegeben wird.

Details zu Architektur & Funktionsweise neuronaler Netze, Forwardpropagation, Backwordpropagation, Hyperparameter, Aktivierungsfunktion sowie Kostenfunktion findet ihr im Impuls Architektur und Funktionsweise von neuronalen Netzen.

M wie:

M wie: Machine Learning

Definition Machine Learning

- Machine Learning ist ein Teilgebiet der Künstlichen Intelligenz, das sich darauf konzentriert, Algorithmen zu entwickeln, die aus Daten lernen können, ohne explizit programmiert zu werden.

- Durch die Generierung von Wissen aus Erfahrungen lernen künstliche Systeme aus Beispielen und können diese nach Abschluss der Lernphase verallgemeinern. Das bedeutet, es werden nicht einfach die Beispiele auswendig gelernt, sondern es erkennt Muster und Gesetzmäßigkeiten in den Lerndaten.

- Durch einen Lerntransfer kann das System auch unbekannte Daten beurteilen oder aber aufgrund einer Überanpassung des Modells an die Trainingsdaten am Lernen unbekannter Daten scheitern.

Methoden Maschinelles Lernen

- Regressionsverfahren: Linear Regression, Random Forest Regression, Gradient Boosting Regression

- Klassifikationsverfahren: Logistische Regression, k-Nearest Neighbour, Support Vector Machines

- Clustering: k-Means Clustering, DBSCAN

Anwendungsmöglichkeiten Machine Learning

- Empfehlungssysteme

- Betrugserkennung

- medizinische Diagnose

- Spam-Erkennung

- Gesichtserkennung

- Finanzprognosen

M wie: Microsoft Fabric

Microsoft Fabric ist eine End-to-End Datenplattform für Datenintegration, Data Engineering, Data Science, Data Warehousing, Echtzeitanalysen und Business Intelligence. Somit bietet Microsoft Fabric eine All-in-One Lösung zur Erfassung, Verarbeitung, Speicherung und Analyse von Daten in einer einheitlichen Umgebung.

OneLake

Die Basis für die Software-as-a-Service-Plattform (SaaS) in der Azure Cloud bildet der OneLake. OneLake ist die Lake-basierte Architektur, welche ähnlich wie OneDrive als zentraler Datenspeicher fungiert. Durch die Verbindung verschiedener Speicherstandorte zu einem einzigen Lake, müssen die Daten nicht mehr zwischen unterschiedlichen Systemen verschoben oder kopiert werden. OneLake basiert auf Azure Data Lake Storage (ADLS), sodass Daten in jedem Dateiformat gespeichert werden können. Für Tabellendaten wird dabei das Delta-Parquet-Format genutzt.

Komponenten von Fabric

Durch die Integration verschiedener Azure Dienste bietet Fabric eine umfassende Plattform zur Datenanalyse. Dazu gehören die Azure Data Factory zur Datenintegration, Power BI zur Datenanalyse und Azure Synapse für Data Warehousing, Datentransformationen mit Spark, Data Science mit Azure Machine Learning sowie Echtzeitanalysen von großen Datenmengen.

Data Governance

Durch die zentrale Speicherung im OneLake können Governance- und Sicherheitsrichtlinien für alle Komponenten einfach erstellt und kontrolliert werden. Im Admin Center können Nutzergruppen und Berechtigungen verwaltet, Datenquellen und Gateways konfiguriert sowie die Nutzung und Leistung überwacht werden. Zudem verwendet Fabric die Vertraulichkeitsbezeichnungen von Microsoft Purview Information Protection zum Klassifizieren und Schutz vertraulicher Daten.

M wie: MicroStrategy

Einführung MicroStrategy

MicroStrategy ist eine leistungsstarke Business Intelligence (BI)-Plattform, die Unternehmen bei der Analyse und Visualisierung ihrer Daten unterstützt, um fundierte Geschäftsentscheidungen zu treffen. Insgesamt bietet MicroStrategy eine umfassende Lösung für Unternehmen, die Daten in wertvolle Informationen verwandeln möchten, um strategische Entscheidungen zu treffen und ihre Leistung zu verbessern. Es ist eine wertvolle Ressource für das Datenmanagement und die Business Intelligence.

Hier sind einige wichtige Aspekte und Funktionen von MicroStrategy.

Berichterstellung und Visualisierung

MicroStrategy ermöglicht es Benutzern, Berichte und Dashboards zu erstellen, die Daten aus verschiedenen Quellen kombinieren und in leicht verständlichen Grafiken, Diagrammen und Tabellen darstellen. Diese visuellen Elemente helfen Benutzern dabei, Muster, Trends und Erkenntnisse aus den Daten zu gewinnen.

Datenaufbereitung

Das BI-Tool bietet umfangreiche Datenaufbereitungsfunktionen, mit denen Daten gereinigt, transformiert und modelliert werden können. Dies erleichtert die Integration von Daten aus unterschiedlichen Quellen und deren Anpassung an die spezifischen Anforderungen des Unternehmens.

Self-Service-Analyse

MicroStrategy ermöglicht es nicht nur IT-Experten, sondern auch Geschäftsanwendern, Analysen durchzuführen. Benutzer können Daten eigenständig abfragen und visualisieren, ohne auf umfangreiche IT-Unterstützung angewiesen zu sein.

Mobile BI

Die Plattform bietet mobile Anwendungen, mit denen Benutzer von ihren Mobilgeräten aus auf Echtzeitdaten und Berichte zugreifen können. Dies erleichtert die Entscheidungsfindung, auch wenn man unterwegs ist.

Skalierbarkeit und Sicherheit

MicroStrategy ist sowohl für kleine Unternehmen als auch für große Konzerne geeignet. Es bietet Skalierbarkeit und leistungsstarke Sicherheitsfunktionen, um die Vertraulichkeit und Integrität der Daten zu gewährleisten.

Integration

Die Plattform lässt sich nahtlos in bestehende IT-Infrastrukturen integrieren und kann Daten aus einer Vielzahl von Quellen, einschließlich relationalen Datenbanken, Big Data-Systemen und Cloud-Diensten, abrufen.

In-Memory-Verarbeitung

MicroStrategy verwendet In-Memory-Technologie, um Daten für schnelle Abfragen und Analysen im Arbeitsspeicher zu halten. Dies führt zu beschleunigten Berichterstellungs- und Analyseprozessen.

Predictive Analytics

Neben der reinen Datenvisualisierung bietet MicroStrategy auch Predictive Analytics-Funktionen, die Vorhersagen und Empfehlungen basierend auf historischen Daten treffen können.

Berichtsautomatisierung

Es ermöglicht die Automatisierung von Berichts- und Benachrichtigungsprozessen, um Benutzern regelmäßig aktualisierte Informationen zuzusenden.

Cloud- und On-Premises-Optionen

MicroStrategy kann sowohl in der Cloud als auch lokal installiert werden, um den individuellen Anforderungen und Präferenzen von Unternehmen gerecht zu werden.

M wie: MongoDB

Einführung MongoDB

MongoDB ist eine dokumentenorientierte NoSQL-Datenbank, die in vielen Anwendungsfällen weit verbreitet ist, darunter Webanwendungen, Mobile Apps, Echtzeit-Analytik, IoT und Content-Management-Systeme. Es bietet Entwicklern die Flexibilität und Leistung, um moderne Anwendungen zu erstellen, die große Datenmengen verarbeiten müssen.

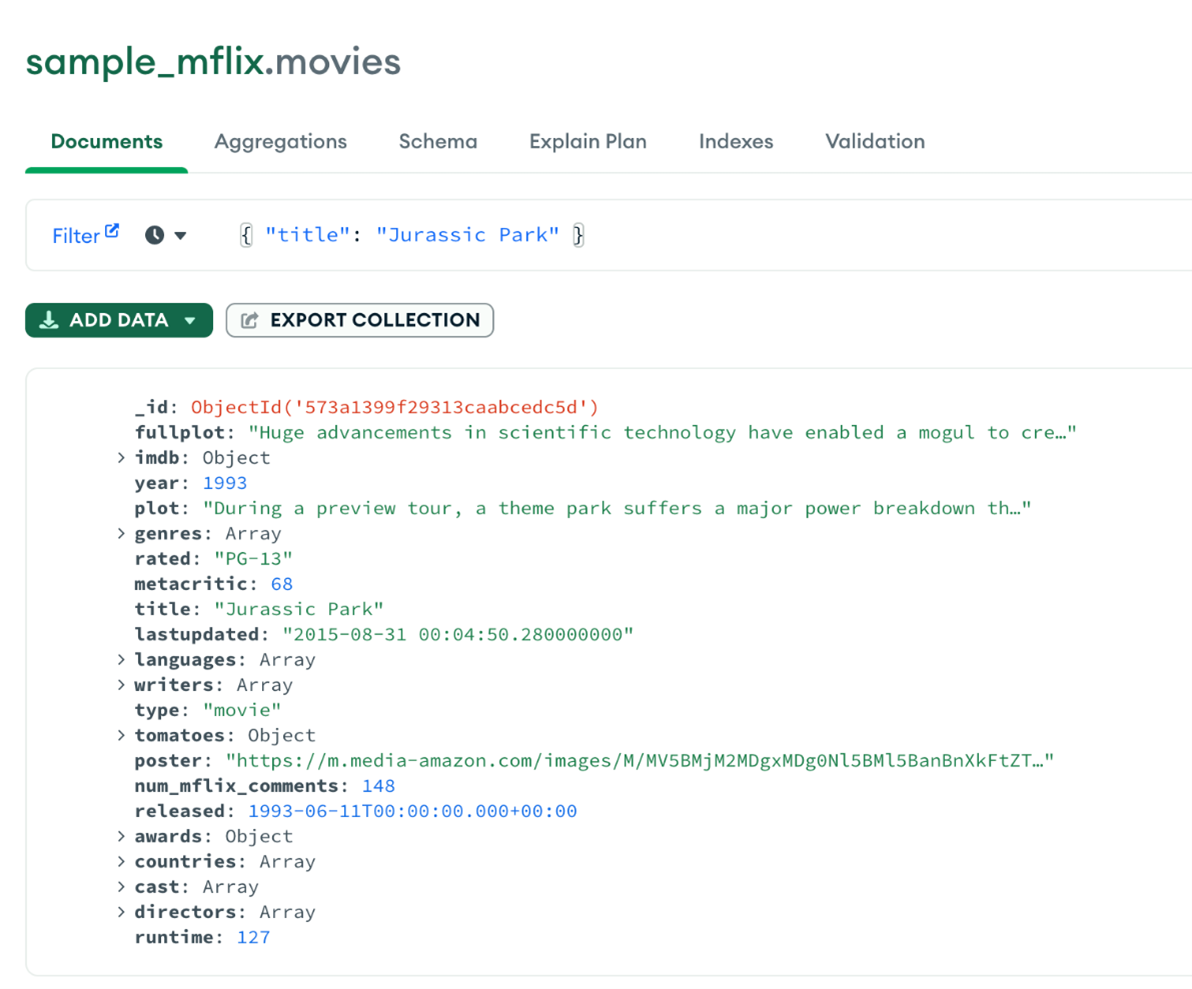

Dokumentenorientiertes Datenmodell

MongoDB verwendet ein dokumentenorientiertes Datenmodell. Ein Dokument ist eine Sammlung von Feld-Wert-Paaren, ähnlich wie ein JSON-Objekt. Diese flexiblen und schemalosen Dokumente ermöglichen es Entwicklern, Daten auf natürliche und hierarchische Weise zu modellieren, ohne an ein starres Schema gebunden zu sein. So können Datenmodelle agil angepasst und erweitert werden, ohne das Schema oder die Anwendung zu ändern. Dies macht MongoDB besonders geeignet für agile Entwicklungsumgebungen, in denen sich Anforderungen häufig ändern.

Abfragemöglichkeiten MongoDB

MongoDB bietet zudem flexible Abfragemöglichkeiten. Es unterstützt ein Abfragesystem, das Indexierung, Filterung, Projektion, Sortierung und Aggregation ermöglicht. Die Abfragen werden mit einer intuitiven Abfragesprache namens MongoDB Query Language (MQL) formuliert, die leicht zu erlernen und zu verwenden ist.

M wie: MongoDB Compass

Einführung MongoDB Compass

MongoDB Compass ist ein grafisches Tool zur Verwaltung und Visualisierung von Daten in MongoDB-Datenbanken. Es bietet einen leistungsfähigen Abfrageeditor, mit dem Sie Abfragen in der MongoDB Query Language (MQL) erstellen und ausführen können.

Mit MongoDB Compass können Sie Datenbanken und Collections erstellen, umbenennen, löschen und verwalten. Sie können Indizes definieren und verwalten, um die Abfrageleistung zu optimieren, und Zugriffsrechte sowie Sicherheitseinstellungen konfigurieren.

Zudem bietet MongoDB Compass eine nahtlose Integration mit MongoDB Atlas und Azure CosmosDB.

Import & Export von Daten

MongoDB Compass ermöglicht es Ihnen, Daten aus verschiedenen Quellen in Ihre MongoDB-Datenbanken zu importieren. Sie können Daten aus JSON-, CSV- oder BSON-Dateien importieren oder aus anderen Datenbanken migrieren. Darüber hinaus können Sie Daten aus Ihrer MongoDB-Datenbank in verschiedene Formate exportieren, um sie in anderen Tools oder Anwendungen zu verwenden.

N wie:

N wie: Neuronales Netz

Einführung in neuronale Netze